خلاصه مقاله

مقاله “هوش مصنوعی: انقلاب” نوشته تیم اوربان به عمق بیشتری از پیچیدگیهای هوش مصنوعی، به ویژه مفهوم هوش مصنوعی فوقالعاده (ASI) میپردازد.

نکات کلیدی مقاله

- سرعت پیشرفت فناوری: مقاله به رشد نمایی قدرت محاسباتی و تأثیرات آن بر توسعه هوش مصنوعی اشاره میکند. این مقاله نشان میدهد که ممکن است به ایجاد هوش مصنوعی ابرهوشمند نزدیکتر باشیم از آنچه تصور میکنیم.

- انفجار هوش: یک مفهوم کلیدی “انفجار هوش” است، جایی که یک هوش مصنوعی از هوش انسان فراتر رفته و به سرعت خود را بهبود میبخشد و به سطح هوشی بسیار فراتر از درک انسان میرسد.

- مزایای بالقوه: نویسنده به پتانسیل عظیم ASI میپردازد، از جمله حل مشکلات جهانی مانند تغییرات آب و هوایی، بیماریها و فقر. همچنین میتواند منجر به پیشرفتهای علمی و پیشرفت در زمینههای مختلف شود.

- خطر وجودی: بخش قابل توجهی از مقاله بر خطرات بالقوه ASI تمرکز دارد. سناریوهایی را مورد بحث قرار میدهد که در آن اهداف یک هوش مصنوعی با ارزشهای انسانی همسو نبوده و منجر به عواقب فاجعهبار میشود. مفهوم “مشکل کنترل” معرفی شده است که بر اهمیت اطمینان از تراز بودن یک هوش مصنوعی ابرهوشمند با منافع انسانی تأکید میکند.

- جدول زمانیهای مختلف: مقاله دیدگاههای مختلفی را در مورد جدول زمانی توسعه ASI ارائه میدهد، از دیدگاههای خوشبینانه چند دهه تا برآوردهای محتاطانهتر چند قرن.

- اهمیت توسعه دقیق: نویسنده بر لزوم برنامهریزی و تحقیق دقیق برای اطمینان از همسو بودن توسعه ASI با ارزشها و ایمنی انسان تأکید میکند.

توجه: این ترجمه ماشینی (با کمی اصلاح و ویرایش) از مقاله بسیار خواندنی با عنوان “The AI Revolution: The Road to Superintelligence” وبسایت Wait But why است. منتشر شده در سال ۲۰۱۵. ترجمه قسمت قبل در اینجاست.

PDF: ما یک PDF فانتزی از این پست برای چاپ و مشاهده آفلاین تهیه کردیم. از اینجا بخر (یا یک پیش نمایش را ببینید .)

توجه: این قسمت ۲ از یک مجموعه دو قسمتی در زمینه هوش مصنوعی است. قسمت ۱ اینجاست .

___________

ما مشکلی داریم که ممکن است بسیار دشوار باشد با زمان نامعلومی برای حل آن، که احتمالاً کل آینده بشریت به آن بستگی دارد. – نیک بوستروم

به قسمت ۲ از مجموعه “صبر کنید چگونه این احتمالاً چیزی است که من می خوانم، من نمی فهمم چرا همه در مورد این موضوع صحبت نمی کنند” خوش آمدید.

بخش ۱ به اندازه کافی بیگناه شروع شد، زیرا در مورد هوش باریک مصنوعی یا ANI (هوش مصنوعی که در یک کار باریک مانند ایجاد مسیرهای رانندگی یا بازی شطرنج تخصص دارد) و چگونگی وجود آن در سراسر جهان امروز صحبت کردیم. سپس بررسی کردیم که چرا رسیدن از ANI به هوش عمومی مصنوعی یا AGI (AI که حداقل به اندازه یک انسان توانایی عقلانی دارد)، و بحث کردیم که چرا سرعت نمایی پیشرفت تکنولوژی ما چیست؟ دیده شده در گذشته نشان می دهد که AGI ممکن است آنقدر که به نظر می رسد دور نباشد. قسمت ۱ با حمله من به شما با این واقعیت به پایان رسید که هنگامی که ماشین های ما به هوش سطح انسانی رسیدند، ممکن است فوراً این کار را انجام دهند:

این باعث شد که به صفحه نمایش خیره شویم، و با مفهوم شدید ابرهوش مصنوعی بالقوه در زندگی خود، یا ASI (هوش مصنوعی که بسیار باهوشتر از هر انسان دیگری است)، روبرو شویم و سعی کنیم بفهمیم قرار است کدام احساس را داشته باشیم. همانطور که در مورد آن فکر می کردیم ادامه دهید.۱۱← اینها را باز کنید

قبل از اینکه در مورد چیزها غوطه ور شویم، بیایید به خود یادآوری کنیم که فوق هوشمند بودن یک ماشین چه معنایی دارد.

یک تمایز کلیدی تفاوت بین ابرهوش سرعت و ابرهوش کیفیت است . اغلب، اولین فکر کسی که تصور میکند یک کامپیوتر فوقهوشمند را تصور میکند، کامپیوتری است که مانند یک انسان باهوش است، اما میتواند خیلی خیلی سریعتر فکر کند.۲آنها ممکن است ماشینی را به تصویر بکشند که مانند یک انسان فکر میکند، به جز میلیونها بار سریعتر، که به این معنی است که میتواند در عرض پنج دقیقه بفهمد که یک دهه چقدر طول میکشد.

این تاثیرگذار به نظر میرسد، و ASI خیلی سریعتر از هر انسانی فکر میکند – اما جداکننده واقعی مزیت آن در کیفیت هوش است ، که چیزی کاملاً متفاوت است. چیزی که انسان ها را از نظر عقلی بسیار بیشتر از شامپانزه ها می کند، تفاوت در سرعت فکر نیست – بلکه این است که مغز انسان دارای تعدادی ماژول های شناختی پیچیده است که چیزهایی مانند بازنمایی های پیچیده زبانی یا برنامه ریزی طولانی مدت یا استدلال انتزاعی را امکان پذیر می کند، که مغز شامپانزه ها این کار را نمی کند. . هزاران بار سرعت بخشیدن به مغز یک شامپانزه او را به سطح ما نمی رساند – حتی با گذشت یک دهه، او نمی تواند بفهمد چگونه از مجموعه ای از ابزارهای سفارشی برای مونتاژ یک مدل پیچیده، چیزی شبیه به انسان استفاده کند. می تواند در چند ساعت ناک اوت شود دنیاهایی از عملکرد شناختی انسان وجود دارد که یک شامپانزه به سادگی قادر به انجام آنها نیست، مهم نیست چقدر زمان صرف تلاش می کند.

اما مسئله فقط این نیست که یک شامپانزه نمیتواند کاری را که ما انجام میدهیم انجام دهد، بلکه مغز او قادر به درک وجود آن دنیاها نیست – یک شامپانزه میتواند با چیستی انسان و آسمانخراش آشنا شود، اما هرگز نمیتواند قادر به درک اینکه آسمان خراش توسط انسان ساخته شده است . در دنیای او، هر چیزی که بزرگ باشد بخشی از طبیعت، دوره است، و نه تنها ساختن آسمان خراش فراتر از اوست، بلکه درک اینکه هرکسی می تواند آسمان خراش بسازد، فراتر از اوست. این نتیجه یک تفاوت کوچک در کیفیت هوش است.

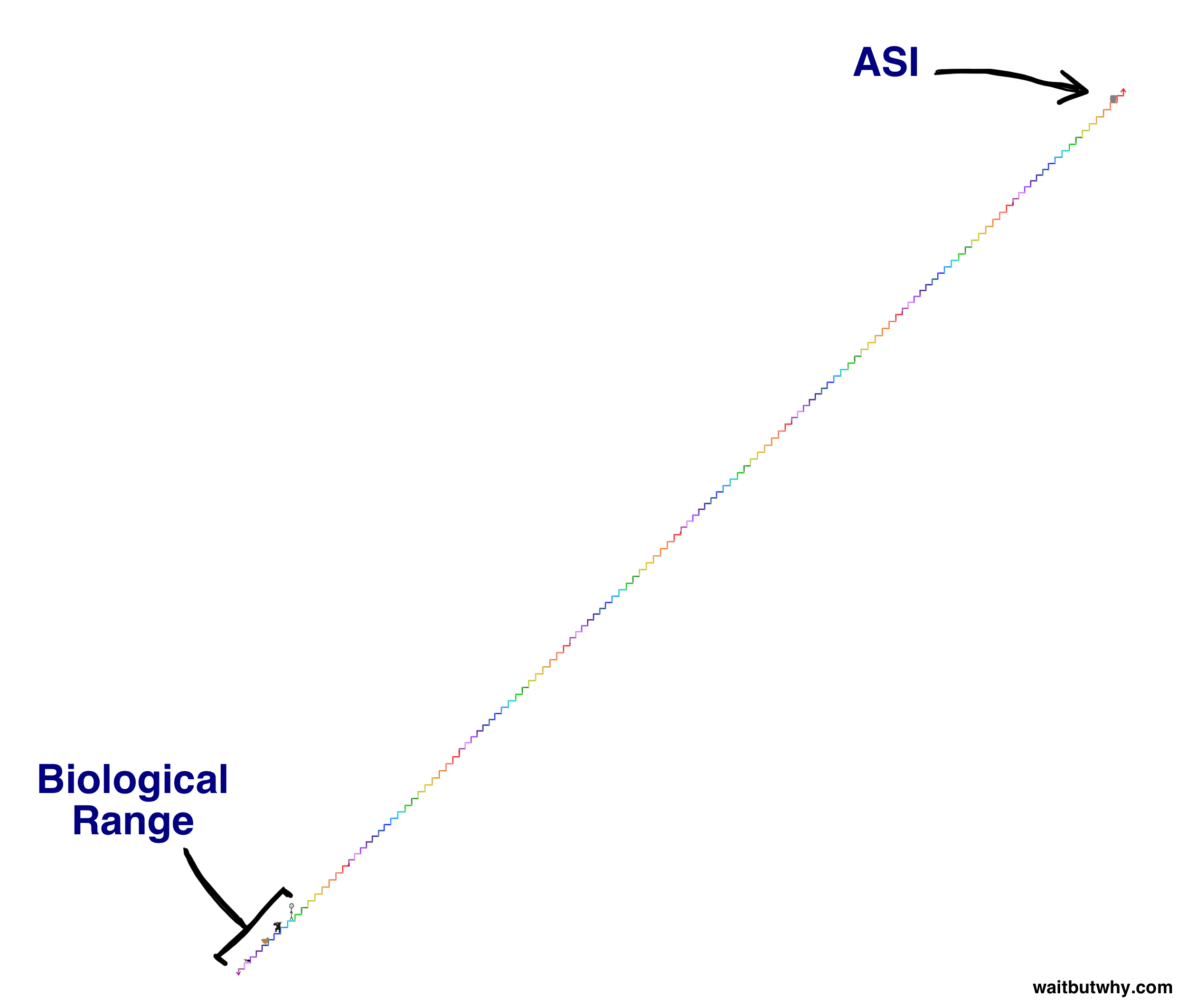

و در طرح محدوده هوشی که امروز در مورد آن صحبت می کنیم، یا حتی محدوده بسیار کوچکتر در میان موجودات زیستی، شکاف هوشی کیفیت شامپانزه به انسان بسیار ناچیز است . در پست قبلی ، محدوده ظرفیت شناختی بیولوژیکی را با استفاده از یک راه پله به تصویر کشیدم:۳

برای درک اینکه یک ماشین فوق هوشمند چقدر کار بزرگی خواهد بود، ماشینی را روی پله سبز تیره دو پله بالاتر از انسان در آن پلکان تصور کنید. این ماشین فقط کمی فوق هوشمند خواهد بود، اما افزایش توانایی شناختی آن بر ما به اندازه شکاف شامپانزه-انسان که قبلاً توضیح دادیم، گسترده خواهد بود. و مانند ناتوانی شامپانزه در جذب آسمانخراشهایی که میتوان ساخت، ما هرگز قادر نخواهیم بود حتی کارهایی را که یک ماشین روی پله سبز تیره میتواند انجام دهد را درک کنیم، حتی اگر ماشین سعی کند آن را برای ما توضیح دهد – چه رسد به اینکه خودمان این کار را انجام دهیم. . و این فقط دو پله بالاتر از ماست. ماشینی که بر روی پله دوم به بلندترین پله پلکان قرار دارد، برای ما مانند مورچهها خواهد بود – میتواند سالها تلاش کند تا سادهترین تصورات را از آنچه میداند به ما بیاموزد و این تلاش ناامیدکننده خواهد بود.

اما نوع ابرهوشی که امروز در مورد آن صحبت می کنیم چیزی فراتر از هر چیزی در این راه پله است. در یک انفجار اطلاعاتی – جایی که یک ماشین هوشمندتر می شود، سریعتر می تواند هوش خود را افزایش دهد، تا زمانی که شروع به اوج گرفتن به سمت بالا کند – ممکن است یک ماشین سال ها طول بکشد تا از پله شامپانزه به پله بالای آن برسد، اما شاید فقط چند ساعت طول بکشد. وقتی روی پله سبز تیره دو بالای ما قرار گرفت، یک پله بالا پرید، و زمانی که ده پله بالاتر از ما قرار گرفت، ممکن است هر ثانیه که می گذرد با چهار پله پرش بالا می رود. به همین دلیل است که ما باید بدانیم که این امکان کاملاً مشخص است که مدت کوتاهی پس از خبر بزرگ در مورد اولین ماشینی که به AGI در سطح انسان می رسد، ممکن است با واقعیت همزیستی روی زمین با چیزی که در اینجا روی پلکان است (یا شاید) روبرو شویم. یک میلیون برابر بیشتر):

و از آنجایی که ما به تازگی ثابت کردیم که تلاش برای درک قدرت یک ماشین تنها دو پله بالاتر از ما یک فعالیت ناامیدکننده است، بیایید یک بار برای همیشه به طور دقیق بیان کنیم که هیچ راهی برای دانستن اینکه ASI چه خواهد کرد یا عواقب آن چه خواهد بود وجود ندارد. برای ما. هرکسی که خلاف این را وانمود می کند، نمی فهمد ابرهوشی یعنی چه.

تکامل مغز بیولوژیکی را به آرامی و به تدریج طی صدها میلیون سال پیشرفت داده است، و از این نظر، اگر انسان ها یک دستگاه ASI را به دنیا بیاورند، به طرز چشمگیری بر روی تکامل لگدمال می کنیم. یا شاید این بخشی از تکامل باشد – شاید روشی که تکامل کار میکند این باشد که هوش بیشتر و بیشتر میخزد تا زمانی که به سطحی میرسد که قادر به ایجاد ابرهوش ماشینی است، و آن سطح مانند سیمی است که باعث ایجاد یک انفجار جهانی میشود که بازی را تغییر میدهد. آینده جدیدی را برای همه موجودات زنده تعیین می کند:

و به دلایلی که بعداً در مورد آنها صحبت خواهیم کرد، بخش بزرگی از جامعه علمی معتقدند که مهم این نیست که آیا ما به آن سه سیم ضربه می زنیم یا نه، بلکه مهم این است که چه زمانی. یک نوع اطلاعات دیوانه کننده.

بنابراین این ما را به چه نتیجه ای میرساند؟

خوب، هیچ کس در دنیا، به خصوص نه من، نمی تواند به شما بگوید که چه اتفاقی می افتد وقتی که ما به سیم تریپ برخورد کنیم. اما نیک بوستروم، فیلسوف آکسفورد و متفکر اصلی هوش مصنوعی معتقد است که میتوانیم همه نتایج بالقوه را به دو دسته کلی تقسیم کنیم.

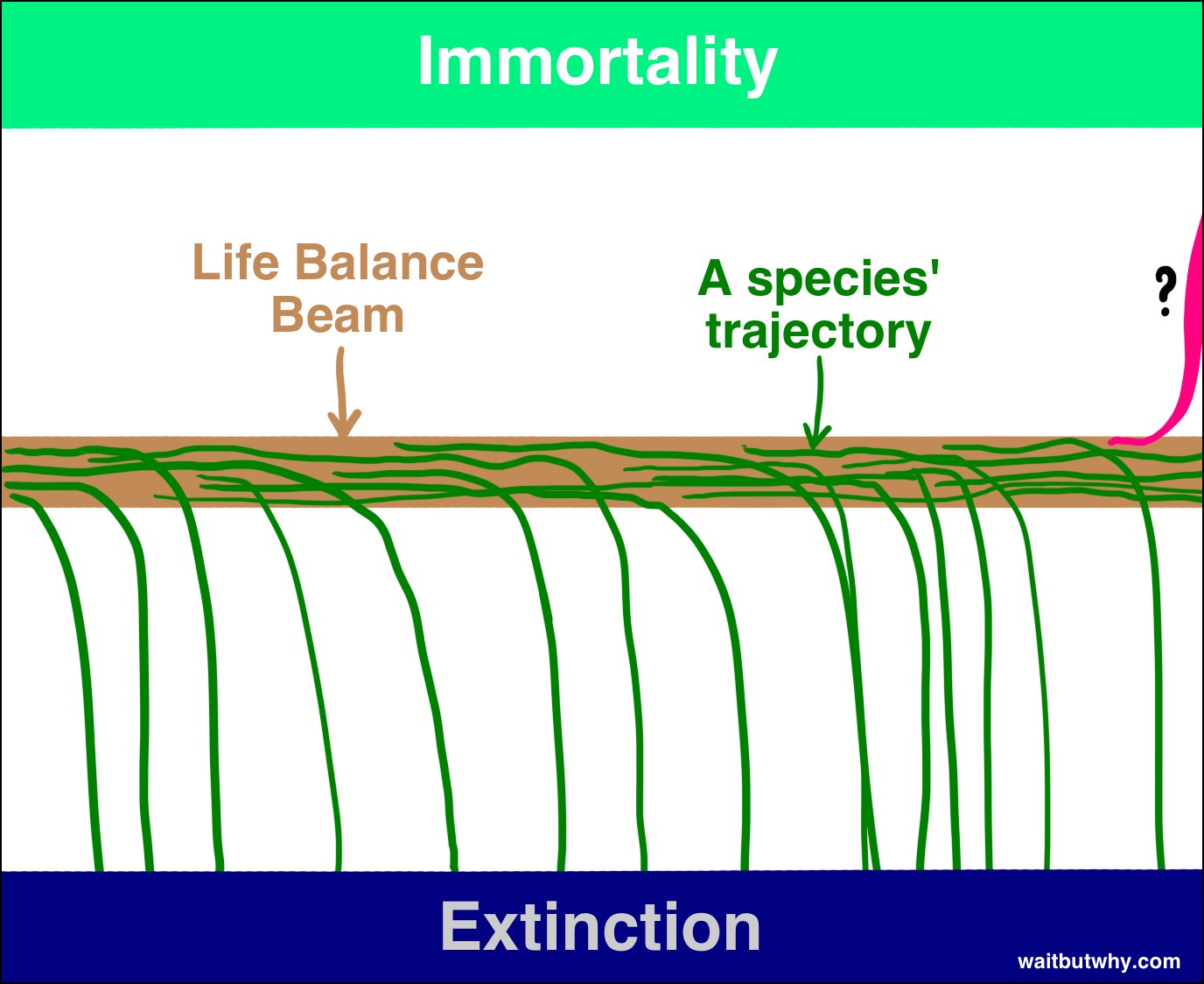

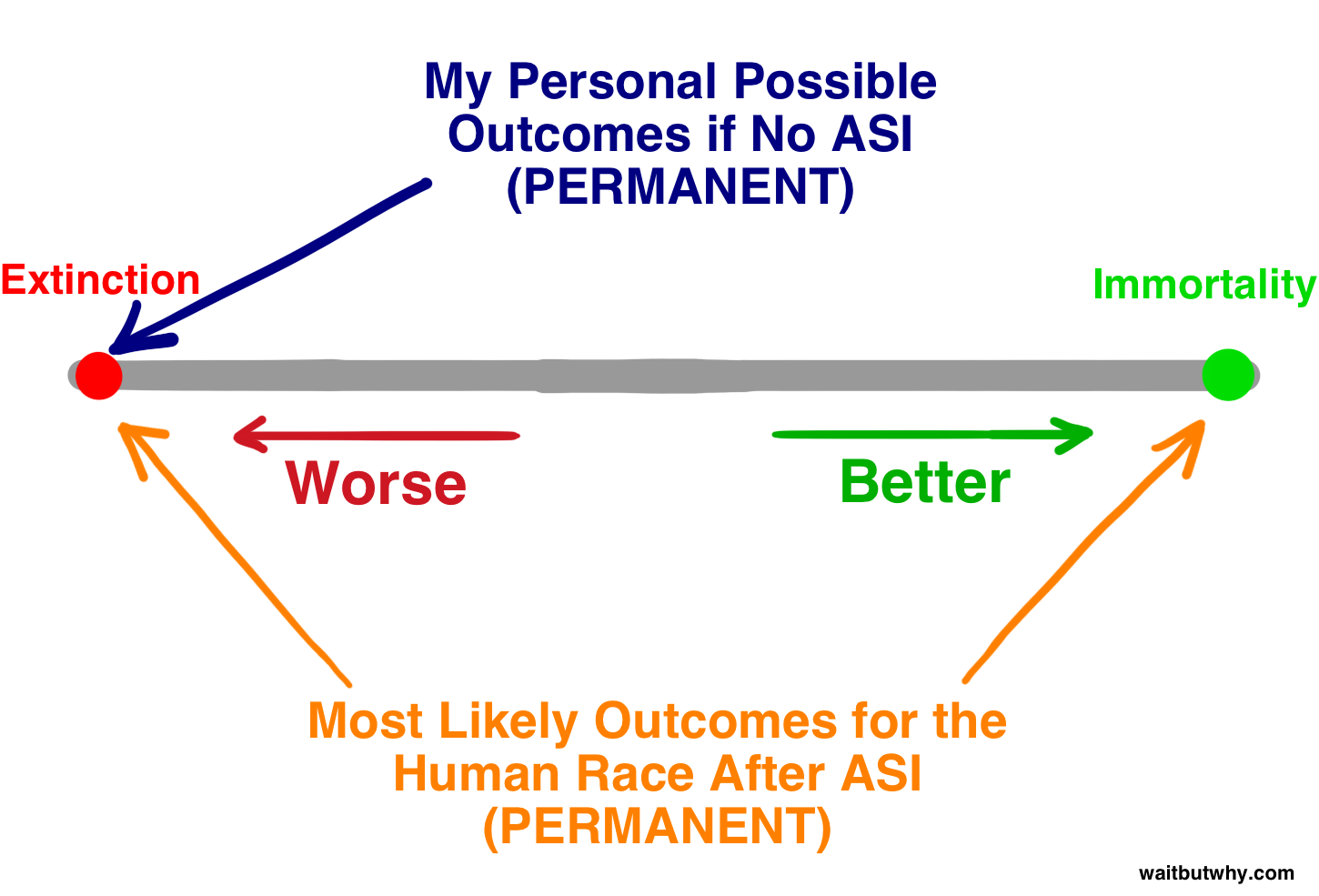

ابتدا، با نگاهی به تاریخ، میتوانیم ببینیم که زندگی به این صورت عمل میکند: گونهها ظاهر میشوند، برای مدتی وجود دارند، و پس از مدتی، ناگزیر از پرتو تعادل هستی میافتند و در معرض انقراض قرار میگیرند.

«همه گونهها در نهایت منقرض میشوند» تقریباً به همان اندازه قابل اعتماد در طول تاریخ بوده است که «همه انسانها در نهایت میمیرند». تاکنون ۹۹.۹ درصد از گونهها از پرتو تعادل سقوط کردهاند، و کاملاً واضح به نظر میرسد که اگر گونهای همچنان در طول پرتو تکان میخورد، چند گونه دیگر، وزش باد طبیعت یا ناگهانی یک موضوع زمان است. سیارک پرتو تکان آن را می زند. بوستروم انقراض را یک حالت جاذب می نامد – مکانی که گونه ها همه در حال سقوط در آن هستند و هیچ گونه ای هرگز از آن باز نمی گردد.

و در حالی که اکثر دانشمندانی که من با آنها برخورد کردهام اذعان دارند که ASI میتواند انسان را به سمت انقراض بفرستد، بسیاری نیز معتقدند که با استفاده مفید، از تواناییهای ASI میتوان برای رساندن انسانها و کل گونهها به یک جاذبه دوم استفاده کرد. حالت-جاودانگی گونه ها. بوستروم معتقد است جاودانگی گونه ها به اندازه انقراض گونه ها یک حالت جذب کننده است، یعنی اگر ما موفق به رسیدن به آنجا شویم، برای همیشه در برابر انقراض نفوذناپذیر خواهیم بود – ما بر مرگ و میر و شانس غلبه خواهیم کرد. بنابراین، با وجود اینکه همه گونهها تاکنون از پرتو تعادل سقوط کرده و در معرض انقراض قرار گرفتهاند، بوستروم معتقد است که دو طرف پرتو وجود دارد و فقط این است که هیچ چیز روی زمین هنوز به اندازه کافی هوشمند نبوده است که بفهمد چگونه میتواند در سمت دیگر سقوط کند. .

اگر بوستروم و دیگران درست میگویند، و با توجه به همه چیزهایی که من خواندهام، به نظر میرسد که واقعاً ممکن است اینطور باشد، دو واقعیت بسیار تکاندهنده برای جذب داریم:

۱) ظهور ASI برای اولین بار امکان فرود یک گونه در سمت جاودانگی پرتو تعادل را فراهم می کند.

۲) ظهور ASI چنان تأثیر شگفتانگیزی ایجاد میکند که احتمالاً نسل بشر را در یک جهت یا جهت دیگر از بین میبرد.

به خوبی ممکن است زمانی که تکامل به سیم تریپ می رسد، رابطه انسان ها با پرتو را برای همیشه خاتمه می دهد و دنیای جدیدی را با یا بدون انسان ایجاد می کند.

به نظر می رسد تنها سوالی که هر انسانی در حال حاضر باید بپرسد این است: چه زمانی قرار است به سیم تریپ برخورد کنیم و زمانی که این اتفاق بیفتد در کدام سمت پرتو فرود خواهیم آمد؟

هیچ کس در جهان پاسخ هر یک از این سؤالات را نمی داند، اما بسیاری از بسیار باهوش ترین افراد چندین دهه برای آن فکر کرده اند. ما بقیه این پست را صرف بررسی آنچه که آنها به دست آورده اند می پردازیم.

___________

بیایید با قسمت اول این سوال شروع کنیم: کی قرار است به تریپ وایر بزنیم؟

یعنی چقدر طول می کشد تا اولین ماشین به ابرهوشی برسد؟

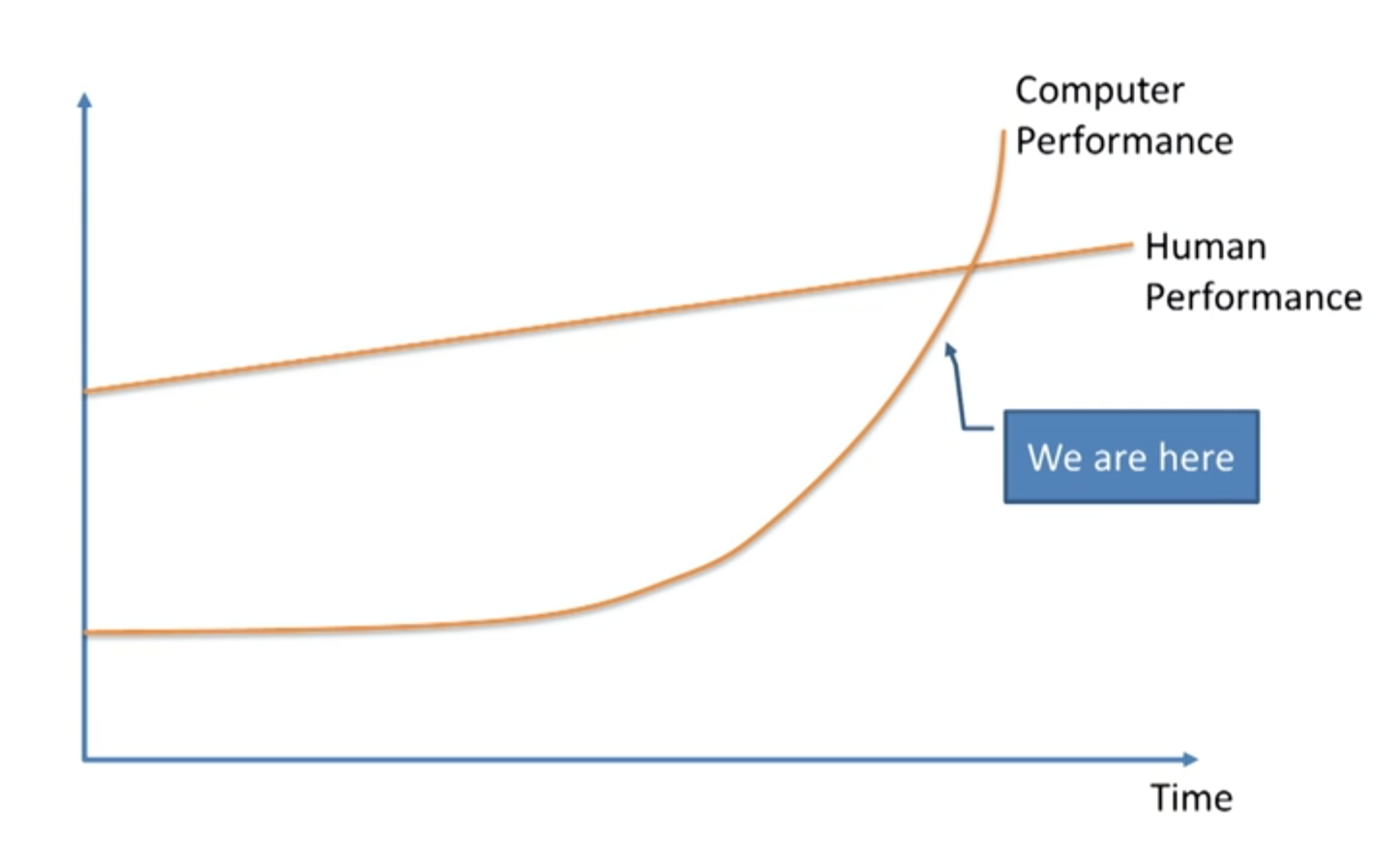

عجیب نیست، نظرات به شدت متفاوت است و این یک بحث داغ بین دانشمندان و متفکران است. بسیاری مانند پروفسور ورنور وینج ، دانشمند بن گورتزل ، بیل جوی ، یکی از بنیانگذاران Sun Microsystems ، یا مشهورترین آنها، مخترع و آینده پژوه ، ری کورزویل ، با جرمی هوارد، متخصص یادگیری ماشین، زمانی که این نمودار را در طول سخنرانی TED ارائه می دهد، موافق هستند :

این افراد معتقدند که این به زودی اتفاق میافتد – که رشد تصاعدی در کار است و یادگیری ماشینی، اگرچه اکنون به آرامی به سمت ما میآید، در چند دهه آینده درست از پیش ما خواهد گذشت.

دیگران، مانند پل آلن ، بنیانگذار مایکروسافت ، گری مارکوس روانشناس پژوهشی ، ارنست دیویس ، دانشمند کامپیوتر دانشگاه نیویورک ، و میچ کاپور ، کارآفرین فناوری ، معتقدند که متفکرانی مانند کورزویل به شدت بزرگی چالش را دست کم می گیرند و معتقدند که ما واقعاً به آن نزدیک نیستیم. به تریپ وایر

اردوگاه کورزویل میگوید که تنها چیزی که در حال رخ دادن است، کمتوجهی به رشد تصاعدی است، و آنها شکها را با کسانی که به نهال کند رشد اینترنت در سال ۱۹۸۵ نگاه میکردند و استدلال میکردند که هیچ راهی وجود ندارد، مقایسه میکنند. به هر چیزی که در آینده نزدیک تاثیرگذار باشد.

مشکوکان ممکن است استدلال کنند که پیشرفت مورد نیاز برای پیشرفت در هوش نیز با هر مرحله بعدی به طور تصاعدی سختتر میشود، که ماهیت نمایی معمولی پیشرفت فناوری را خنثی میکند. و غیره.

اردوگاه سوم، که شامل نیک بوستروم است ، معتقد است که هیچ یک از گروه ها هیچ زمینه ای برای احساس اطمینان در مورد جدول زمانی ندارند و اذعان می کند که الف) این اتفاق می تواند در آینده نزدیک بیفتد و ب) هیچ تضمینی در مورد آن وجود ندارد. همچنین ممکن است زمان بسیار بیشتری طول بکشد.

با این حال، دیگران، مانند فیلسوف هوبرت دریفوس ، معتقدند که هر سه این گروه ساده لوح هستند و معتقدند که حتی یک سیم پیچی وجود دارد، و استدلال میکنند که احتمال اینکه ASI واقعاً هرگز محقق نشود، بسیار ساده لوح هستند.

پس وقتی همه این نظرات را کنار هم می گذارید چه چیزی به دست می آورید؟

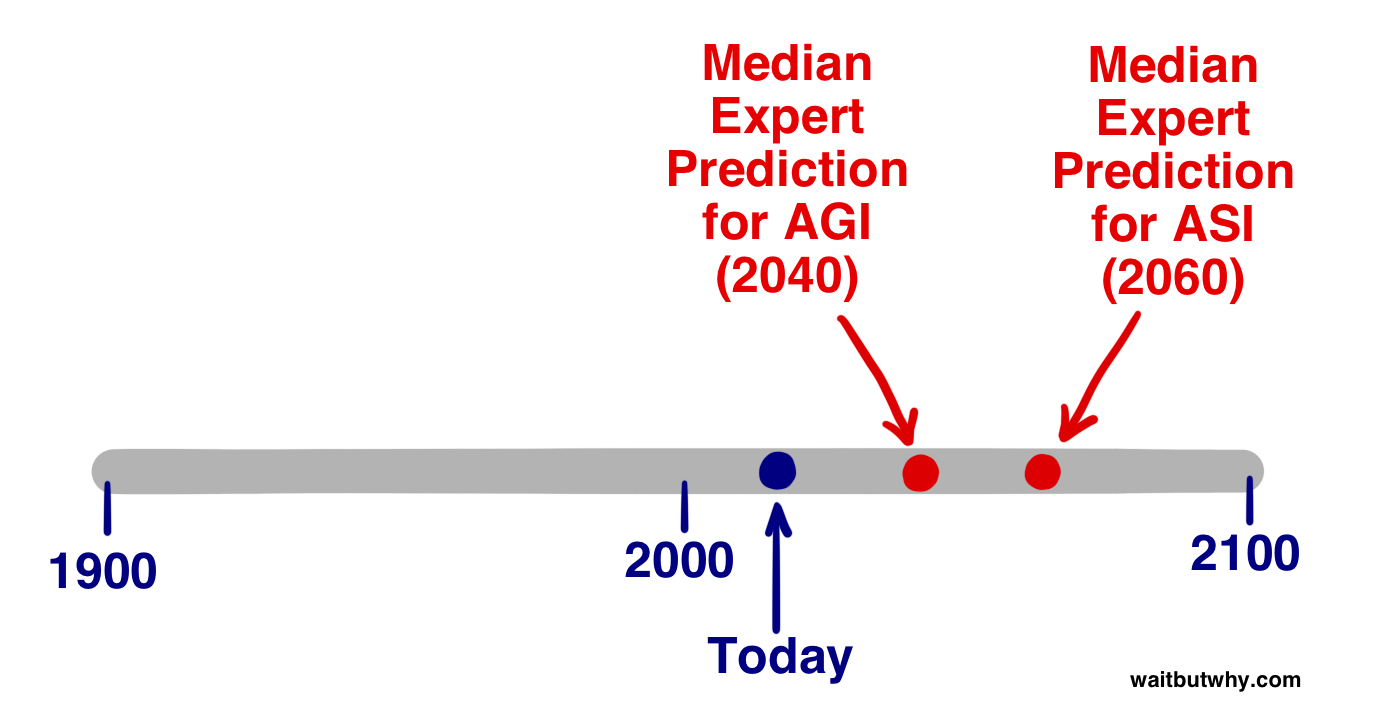

در سال ۲۰۱۳، وینسنت سی مولر و نیک بوستروم نظرسنجی را انجام دادند که در آن از صدها متخصص هوش مصنوعی در مجموعهای از کنفرانسها سؤال زیر پرسیده شد: «برای اهداف این سؤال، فرض کنید که فعالیت علمی انسان بدون اختلال منفی عمده ادامه دارد. در چه سالی احتمال (۱۰% / ۵۰% / ۹۰%) برای چنین HLMI وجود دارد۴خارج شدن؟” از آنها خواسته شد که یک سال خوشبینانه نام ببرند (سالی که معتقدند ۱۰ درصد احتمال دارد که AGI داشته باشیم)، یک حدس واقع بینانه (سالی که معتقدند ۵۰٪ احتمال AGI وجود دارد – یعنی بعد از آن سال آنها فکر می کنند که بیشتر است. به احتمال زیاد ما AGI خواهیم داشت)، و یک حدس مطمئن (اوایل سالی که میتوانند با اطمینان ۹۰ درصدی بگویند که AGI خواهیم داشت). این نتایج به عنوان یک مجموعه داده جمع آوری شده است:۲

میانه سال خوش بینانه (۱۰% احتمال): ۲۰۲۲

میانه سال واقعی (۵۰% احتمال): ۲۰۴۰

میانه سال بدبینانه (۹۰% احتمال): ۲۰۷۵

بنابراین شرکتکننده میانه فکر میکند که احتمال بیشتری وجود دارد که ۲۵ سال آینده AGI داشته باشیم. پاسخ متوسط ۹۰ درصدی ۲۰۷۵ به این معنی است که اگر در حال حاضر یک نوجوان هستید، پاسخگوی متوسط، همراه با بیش از نیمی از گروه متخصصان هوش مصنوعی، تقریباً مطمئن است که AGI در طول زندگی شما اتفاق خواهد افتاد.

مطالعه جداگانهای که اخیراً توسط نویسنده جیمز بارات در کنفرانس سالانه AGI بن گورتزل انجام شد، درصدها را حذف کرد و به سادگی از شرکتکنندگان پرسید که چه زمانی به AGI دست مییابد – تا سال ۲۰۳۰، تا سال ۲۰۵۰، تا سال ۲۱۰۰، پس از سال ۲۱۰۰ یا هرگز. نتایج:۳

تا سال ۲۰۳۰: ۴۲ درصد از پاسخ دهندگان

تا سال ۲۰۵۰: ۲۵ درصد

تا سال ۲۱۰۰: ۲۰ درصد

پس از ۲۱۰۰: ۱۰ درصد

هرگز: ۲ درصد

بسیار شبیه به نتایج مولر و بوستروم. در نظرسنجی Barrat، بیش از دو سوم از شرکت کنندگان معتقدند AGI تا سال ۲۰۵۰ اینجا خواهد بود و کمی کمتر از نیمی از آنها AGI را در ۱۵ سال آینده پیش بینی می کنند. همچنین قابل توجه این است که تنها ۲ درصد از افراد مورد بررسی فکر نمی کنند AGI بخشی از آینده ما باشد.

اما AGI اتصال سیم نیست، ASI است. پس کارشناسان فکر می کنند چه زمانی به ASI می رسیم؟

مولر و بوستروم همچنین از کارشناسان پرسیدند که چقدر احتمال دارد که ما به ASI A) در عرض دو سال پس از رسیدن به AGI (یعنی یک انفجار اطلاعاتی تقریباً فوری) و B) در عرض ۳۰ سال برسیم. نتایج:۴

پاسخ متوسط، انتقال سریع (۲ ساله) AGI → ASI را تنها با احتمال ۱۰٪ ، اما انتقال طولانی تر ۳۰ سال یا کمتر را با احتمال ۷۵٪ نشان می دهد .

ما از این داده ها نمی دانیم که میانگین طول این انتقال احتمال ۵۰ درصدی را برای شرکت کنندگان در نظر می گرفت، اما برای اهداف مهم، بر اساس دو پاسخ بالا، بیایید تخمین بزنیم که آنها ۲۰ سال می گفتند. بنابراین، نظر متوسط - همان نظری که دقیقاً در مرکز دنیای متخصصان هوش مصنوعی قرار دارد – معتقد است که واقعیترین حدس برای اینکه چه زمانی به سیمپیچ ASI برخورد میکنیم [پیشبینی ۲۰۴۰ برای AGI + پیشبینی تخمینی ما از انتقال ۲۰ ساله از AGI به ASI] = 2060 .

البته، تمام آمارهای فوق حدس و گمان هستند و آنها تنها نماینده نظر مرکز جامعه متخصصان هوش مصنوعی هستند، اما به ما می گوید که بخش بزرگی از افرادی که بیشتر در مورد این موضوع می دانند موافق هستند که سال ۲۰۶۰ است. یک تخمین بسیار معقول برای ورود ASI بالقوه در حال تغییر جهان. فقط ۴۵ سال دیگه

خوب حالا قسمت دوم سوال بالا چطور است: وقتی به سیم تریپ برخورد می کنیم، به کدام سمت تیر می افتیم؟

هوش فوقالعاده قدرت فوقالعادهای به همراه خواهد داشت – سوال مهم برای ما این است:

چه کسی یا چه چیزی کنترل آن قدرت را در دست خواهد داشت و انگیزه آنها چه خواهد بود؟

پاسخ به این موضوع مشخص میکند که آیا ASI یک توسعه فوقالعاده باورنکردنی است، یک توسعه وحشتناک غیرقابل درک، یا چیزی در این بین.

البته جامعه کارشناسی باز هم سرتاسر و در حال بحث داغ درباره پاسخ به این سوال است. نظرسنجی مولر و بوستروم از شرکت کنندگان خواست تا احتمالاتی را برای تأثیرات احتمالی AGI بر بشریت تعیین کنند و دریافتند که میانگین پاسخ این بود که ۵۲ درصد احتمال دارد که نتیجه خوب یا بسیار خوب باشد و ۳۱ درصد احتمال نتیجه وجود دارد. یا بد خواهد بود یا بسیار بد. برای یک نتیجه نسبتاً خنثی، میانگین احتمال فقط ۱۷٪ بود. به عبارت دیگر، افرادی که بیشتر در مورد این موضوع می دانند، مطمئن هستند که این یک معامله بزرگ خواهد بود. همچنین شایان ذکر است که این اعداد به ظهور AGI اشاره دارد – اگر سوال در مورد ASI بود، تصور میکنم که درصد خنثی حتی کمتر میشد.

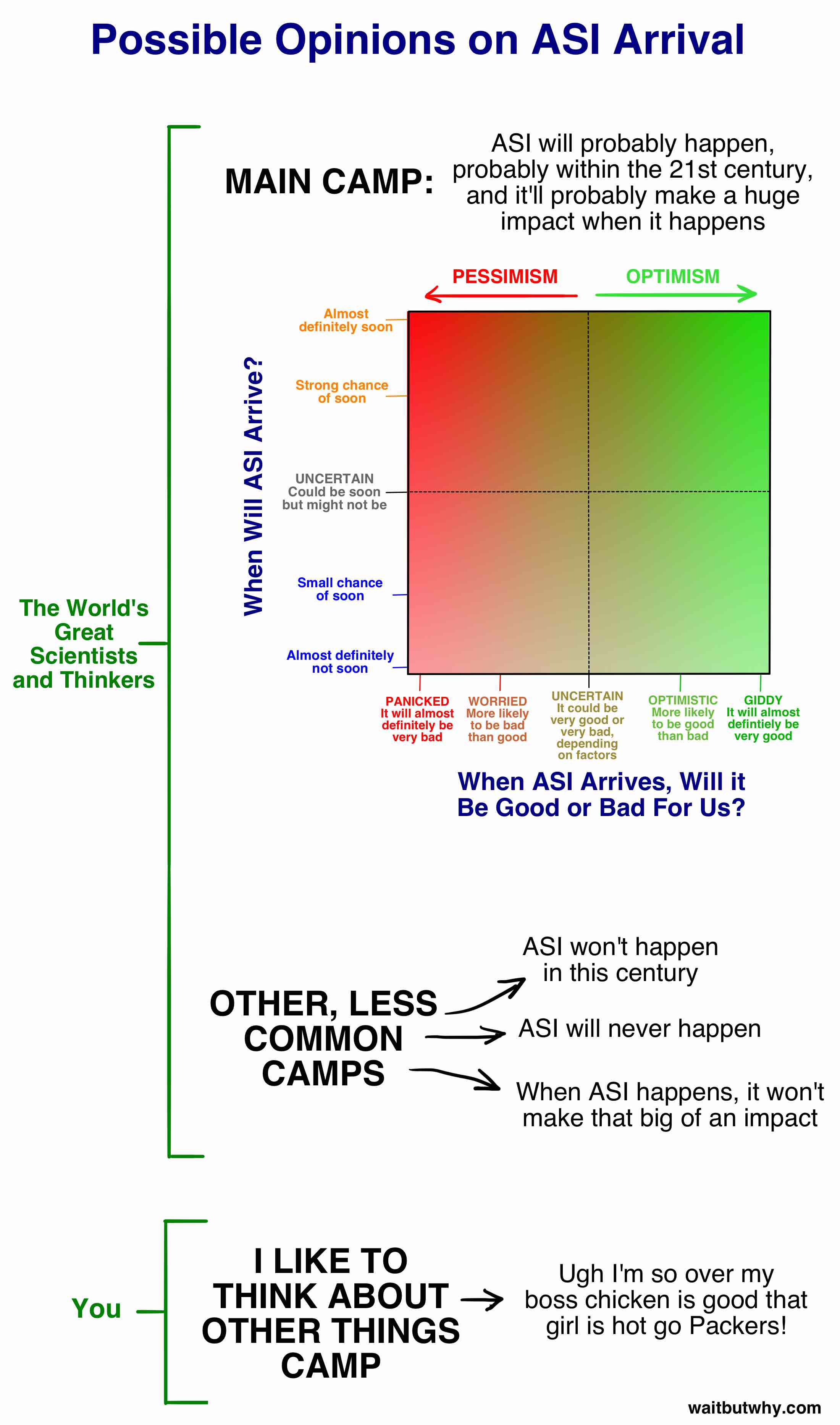

قبل از اینکه خیلی بیشتر در مورد این بخش نتیجه خوب در مقابل بد از سوال غوطه ور شویم، بیایید هر دو عبارت “چه زمانی اتفاق می افتد؟” را با هم ترکیب کنیم. و “آیا خوب خواهد بود یا بد؟” بخش هایی از این سوال در نموداری که نظرات اکثر کارشناسان مربوطه را در بر می گیرد:

در عرض یک دقیقه بیشتر در مورد مین کمپ صحبت خواهیم کرد، اما ابتدا – معامله شما چیست؟ در واقع من می دانم معامله شما چیست، زیرا قبل از شروع تحقیق در مورد این موضوع، این معامله من نیز بوده است. برخی از دلایلی که بیشتر مردم واقعاً به این موضوع فکر نمی کنند:

- همانطور که در قسمت ۱ ذکر شد، فیلم ها با ارائه سناریوهای غیرواقعی هوش مصنوعی که باعث می شود احساس کنیم هوش مصنوعی چیزی نیست که به طور کلی جدی گرفته شود، واقعاً همه چیز را گیج کرده اند. جیمز بارات وضعیت را با واکنش ما مقایسه میکند، اگر مرکز کنترل بیماری هشدار جدی درباره خونآشامها در آینده ما صادر کند.۵

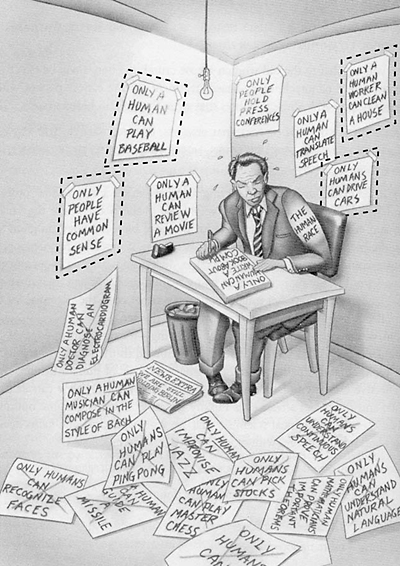

- انسانها تا زمانی که اثباتی را نبینیم، به سختی باور می کنند که چیزی واقعی است. من مطمئن هستم که دانشمندان علوم کامپیوتر در سال ۱۹۸۸ مرتباً در مورد اینکه اینترنت چقدر بزرگ خواهد بود صحبت می کردند، اما مردم احتمالاً واقعاً فکر نمی کردند که زندگی آنها را تغییر دهد تا زمانی که واقعاً زندگی آنها را تغییر دهد. این تا حدی به این دلیل است که کامپیوترها در سال ۱۹۸۸ نمی توانستند چنین کارهایی را انجام دهند، بنابراین مردم به رایانه خود نگاه می کردند و فکر می کردند: “واقعا؟ آیا این تغییر زندگی خواهد بود؟» تصورات آنها محدود به آنچه تجربه شخصی آنها در مورد چیستی رایانه به آنها آموخته بود، محدود بود، و این امر باعث میشد که تصور واضح و روشن رایانهها به چه چیزی تبدیل شوند . همین اتفاق در حال حاضر با هوش مصنوعی در حال رخ دادن است. ما می شنویم که این یک اتفاق بزرگ خواهد بود، اما چون هنوز اتفاق نیفتاده است، و به دلیل تجربه ما با هوش مصنوعی نسبتا ناتوان در دنیای کنونی ما، واقعاً برایمان سخت است که باور کنیم این موضوع زندگی ما را به طرز چشمگیری تغییر خواهد داد. و این تعصبات چیزی است که کارشناسان با آن مقابله می کنند زیرا آنها دیوانه وار سعی می کنند توجه ما را از طریق سر و صدای خود جذبی روزانه جمعی به خود جلب کنند.

- حتی اگر ما آن را باور کنیم – امروز چند بار به این واقعیت فکر کردهاید که بیشتر باقیمانده ابدیت را بدون وجود سپری خواهید کرد؟ زیاد نیست، درست است؟ حتی اگر این یک واقعیت بسیار شدیدتر از هر چیز دیگری است که امروز انجام می دهید؟ این به این دلیل است که مغز ما به طور معمول بر روی چیزهای کوچک در زندگی روزمره متمرکز است، مهم نیست که ما در یک موقعیت طولانی مدت چقدر دیوانه کننده هستیم. این دقیقاً نحوه اتصال ماست.

یکی از اهداف این دو پست این است که شما را از کمپ I Like to Think About Other Things خارج کنید و به یکی از کمپ های متخصص وارد شوید، حتی اگر فقط روی تقاطع دو خط نقطه چین در مربع بالا ایستاده باشید. ، کاملا نامشخص

در طول تحقیقاتم، به ده ها نظر متفاوت در مورد این موضوع برخورد کردم، اما به سرعت متوجه شدم که نظرات اکثر مردم در جایی که من “کمپ اصلی” نامیده بودم، سقوط می کند، و به ویژه، بیش از سه چهارم کارشناسان در دو کمپ فرعی در داخل اصلی قرار گرفتند. کمپ:

ما در هر دوی این اردوگاه ها غواصی خواهیم کرد. بیایید با سرگرم کننده شروع کنیم –

چرا آینده ممکن است بزرگترین رویای ما باشد؟

همانطور که در مورد دنیای هوش مصنوعی یاد گرفتم، تعداد زیادی از مردم را پیدا کردم که اینجا ایستاده اند:

افراد حاضر در Confident Corner از هیجان غوغا می کنند. آنها نگاهشان به سمت سرگرم کننده پرتو تعادل است و متقاعد شده اند که همه ما به این سمت می رویم. برای آنها، آینده هر چیزی است که همیشه می توانستند به آن امید داشته باشند، درست به موقع.

چیزی که این افراد را از متفکران دیگری که بعداً در مورد آنها صحبت خواهیم کرد جدا می کند، شهوت آنها برای طرف شاد پرتو نیست – بلکه اعتماد آنها به این است که ما در آن سمت فرود خواهیم آمد.

اینکه این اطمینان از کجا می آید جای بحث دارد. منتقدان بر این باورند که این هیجان ناشی از هیجانی است که آنقدر کورکننده است که به سادگی پیامدهای منفی بالقوه را نادیده می گیرند یا انکار می کنند. اما مؤمنان میگویند سادهلوحانهای است که سناریوهای روز قیامت را در شرایطی که تعادل برقرار است، تداعی کنیم، فناوری بیشتر از آنکه به ما آسیب بزند، به ما کمک میکند و احتمالاً در نهایت ادامه خواهد داد.

ما هر دو طرف را پوشش میدهیم، و شما میتوانید در حین خواندن نظر خود را در مورد این موضوع بسازید، اما برای این بخش، شک و تردید خود را کنار بگذارید و بیایید نگاه دقیقی به چیزهایی که در آنجا در قسمت سرگرمکننده تیر تعادل وجود دارد بیاندازیم. سعی کنید این واقعیت را درک کنید که چیزهایی که می خوانید ممکن است واقعاً اتفاق بیفتند . اگر به شکارچی-گردآورنده دنیای راحتی، فناوری و فراوانی بیپایان ما را نشان میدادید، برای او یک جادوی تخیلی به نظر میرسید – ما باید آنقدر متواضع باشیم تا بپذیریم که این امکان وجود دارد که تحولی به همان اندازه غیرقابل تصور در ما رخ دهد. آینده.

نیک بوستروم سه راه برای عملکرد یک سیستم هوش مصنوعی فوقهوشمند را شرح میدهد:۶

- به عنوان یک اوراکل ، که تقریباً به هر سؤالی که برایش مطرح می شود، با دقت پاسخ می دهد، از جمله سؤالات پیچیده ای که انسان به راحتی نمی تواند به آنها پاسخ دهد – یعنی چگونه می توانم موتور ماشین کارآمدتری بسازم؟ گوگل یک نوع بدوی اوراکل است.

- به عنوان یک جن ، که هر دستور سطح بالایی را که داده میشود اجرا میکند – از یک اسمبلر مولکولی برای ساخت نوع جدید و کارآمدتر موتور ماشین استفاده کنید – و سپس منتظر دستور بعدی خود میماند.

- بهعنوان یک حاکمیت ، که به او یک تعقیب گسترده و بیپایان اختصاص داده شده است و اجازه دارد آزادانه در جهان فعالیت کند، و تصمیمهای خودش را در مورد بهترین راه ادامه میدهد- راهی سریعتر، ارزانتر و ایمنتر از ماشینها اختراع کنید تا انسانها بتوانند خودشان را به طور خصوصی حمل کنند. .

این سوالات و وظایف، که برای ما پیچیده به نظر میرسند، برای یک سیستم فوقهوشمند مانند کسی به نظر میرسند که از شما میخواهد وضعیت «مداد من از روی میز افتاد» را بهبود بخشید، که با برداشتن آن و قرار دادن دوباره آن روی میز انجام میدهید. جدول.

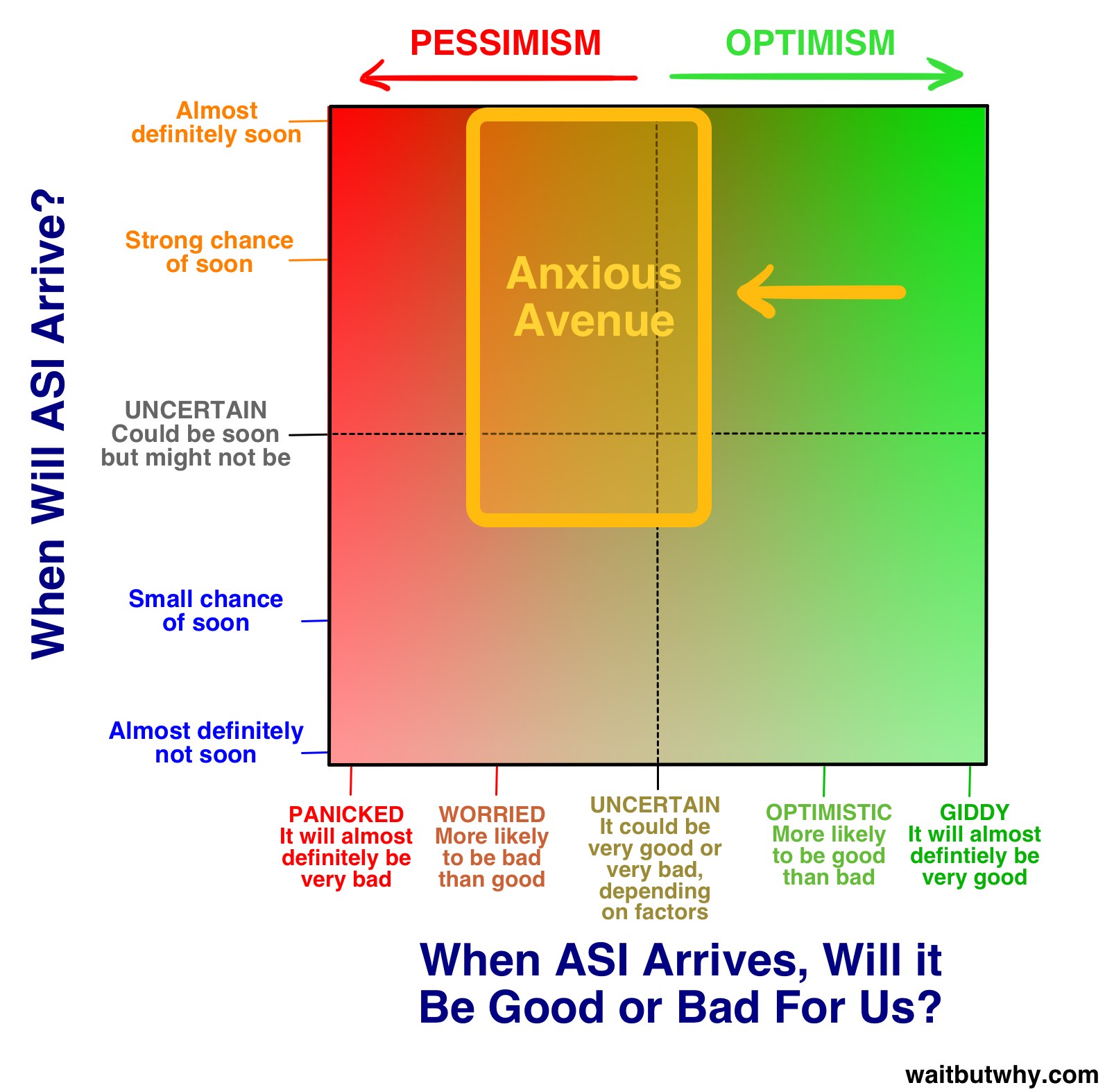

Eliezer Yudkowsky ، ساکن خیابان اضطراب در نمودار بالا، این را به خوبی بیان کرد:

هیچ مشکل سختی وجود ندارد، فقط مشکلاتی وجود دارد که تا سطح مشخصی از هوش سخت هستند. کوچکترین ذره را به سمت بالا [در سطح هوش] حرکت دهید، و برخی از مشکلات ناگهان از “غیر ممکن” به “بدیهی” تغییر خواهند کرد. یک درجه قابل توجه به سمت بالا حرکت کنید و همه آنها آشکار می شوند.۷

تعداد زیادی از دانشمندان، مخترعان و کارآفرینان مشتاق در Confident Corner وجود دارند – اما برای گشت و گذار در روشن ترین سمت افق هوش مصنوعی، تنها یک نفر وجود دارد که ما به عنوان راهنمای تور خود می خواهیم.

ری کورزویل در حال قطبش است. در مطالعهام، همه چیز را شنیدم، از پرستش خداگونه او و عقایدش گرفته تا تحقیر چشمگیر آنها. دیگران جایی در وسط بودند – نویسنده داگلاس هافستادتر، در بحث درباره ایدههای کتابهای کورزویل، به شیوایی بیان کرد که «انگار غذای بسیار خوب و مقداری مدفوع سگ را برداشته و همه را با هم مخلوط کردهاید تا بتوانید. احتمالاً نمی توان فهمید که چه چیزی خوب است یا بد.”۸

چه ایده های او را دوست داشته باشید یا نه، همه موافق هستند که کورزویل چشمگیر است. او از نوجوانی شروع به اختراع چیزهایی کرد و در دهههای بعد، چندین اختراع دست یافت، از جمله اولین اسکنر تخت، اولین اسکنر که متن را به گفتار تبدیل میکرد (به نابینایان اجازه میداد متون استاندارد را بخوانند)، کورزویل معروف. سینت سایزر موسیقی (اولین پیانوی الکتریکی واقعی) و اولین تشخیص گفتار با واژگان بزرگ که به صورت تجاری به بازار عرضه شد. او نویسنده پنج کتاب پرفروش ملی است. او به خاطر پیشبینیهای جسورانهاش مشهور است و سابقه بسیار خوبی در تحقق آنها دارد – از جمله پیشبینی او در اواخر دهه ۸۰، زمانی که اینترنت چیز مبهم بود و در اوایل دهه ۲۰۰۰، اینترنت جهانی خواهد شد. پدیده کورزویل توسط وال استریت ژورنال “نابغه بی قرار”، توسط فوربس “ماشین تفکر نهایی”، توسط مجله Inc. “وارث قانونی ادیسون” و توسط “بهترین فردی که در پیش بینی آینده هوش مصنوعی می شناسم” نامیده می شود. بیل گیتس.۹در سال ۲۰۱۲، لری پیج، یکی از بنیانگذاران گوگل، به کورزویل نزدیک شد و از او خواست تا مدیر مهندسی گوگل شود.۵در سال ۲۰۱۱، او دانشگاه Singularity را تأسیس کرد که توسط ناسا میزبانی می شود و بخشی از آن توسط گوگل حمایت می شود. برای یک زندگی بد نیست

این بیوگرافی مهم است. وقتی کورزویل چشم انداز خود را از آینده بیان می کند، کاملاً شبیه یک دیوونه به نظر می رسد، و نکته دیوانه کننده این است که او اینطور نیست – او مردی بسیار باهوش، آگاه و مرتبط در جهان است. ممکن است فکر کنید که او در مورد آینده اشتباه می کند، اما او احمق نیست. دانستن اینکه او یک شخص قانونی است من را خوشحال می کند ، زیرا از آنجایی که از پیش بینی های او برای آینده مطلع شده ام، شدیداً می خواهم که او درست باشد. و شما نیز انجام دهید. همانطور که پیشبینیهای کورزویل را میشنوید، که بسیاری از متفکران گوشه مطمئن مانند پیتر دیاماندیس و بن گورتزل به اشتراک گذاشته شدهاند ، سخت نیست که بفهمیم چرا او چنین پیروان پرشور و پرشوری دارد – معروف به تکنفرگان. در اینجا چیزی است که او فکر می کند قرار است اتفاق بیفتد:

جدول زمانی

کورزویل معتقد است که کامپیوترها تا سال ۲۰۲۹ به AGI خواهند رسید و تا سال ۲۰۴۵، ما نه تنها ASI، بلکه یک دنیای جدید کامل خواهیم داشت – زمانی که او آن را تکینگی می نامد. جدول زمانی مربوط به هوش مصنوعی او قبلاً بهشدت بیش از حد غیرعادی تلقی میشد، و هنوز هم توسط بسیاری،۶اما در ۱۵ سال گذشته، پیشرفتهای سریع سیستمهای ANI، دنیای بزرگتر کارشناسان هوش مصنوعی را به جدول زمانی کورزویل نزدیکتر کرده است. پیشبینیهای او هنوز کمی جاهطلبانهتر از پاسخدهنده متوسط در نظرسنجی مولر و بوستروم است (AGI تا سال ۲۰۴۰، ASI تا سال ۲۰۶۰)، اما نه تا این حد.

تصویر کورزویل از تکینگی ۲۰۴۵ توسط سه انقلاب همزمان در بیوتکنولوژی، نانوتکنولوژی و از همه مهمتر هوش مصنوعی به وجود آمده است.

قبل از اینکه به جلو برویم—تقریباً در هر چیزی که در مورد آینده هوش مصنوعی می خوانید، فناوری نانو مطرح می شود، بنابراین برای یک دقیقه وارد این جعبه آبی شوید تا بتوانیم درباره آن بحث کنیم—

جعبه آبی فناوری نانو

نانوتکنولوژی کلمه ما برای فناوری است که با دستکاری موادی با اندازه بین ۱ تا ۱۰۰ نانومتر سروکار دارد. نانومتر یک میلیاردیم متر یا یک میلیونیم میلی متر است و این محدوده ۱ تا ۱۰۰ شامل ویروس ها (عرض ۱۰۰ نانومتر)، DNA (عرض ۱۰ نانومتر) و چیزهایی به کوچکی مولکول های بزرگ مانند هموگلوبین (۵ نانومتر) است. و مولکول های متوسط مانند گلوکز (۱ نانومتر). اگر/وقتی نانوتکنولوژی را فتح کنیم، گام بعدی توانایی دستکاری اتمهای منفرد است که فقط یک مرتبه قدر کوچکتر هستند (~.۱ نانومتر).۷

برای درک چالش انسان ها برای دستکاری ماده در آن محدوده، بیایید همین موضوع را در مقیاس بزرگتر در نظر بگیریم. ایستگاه فضایی بین المللی ۲۶۸ مایل (۴۳۱ کیلومتر) بالاتر از زمین قرار دارد. اگر انسانها آنقدر بزرگ بودند که سرشان تا ایستگاه فضایی بینالمللی میرسید، حدود ۲۵۰ هزار برابر بزرگتر از الان بودند. اگر محدوده فناوری نانو ۱ تا ۱۰۰ نانومتری را ۲۵۰۰۰۰ برابر بزرگتر کنید، ۲۵/۲ تا ۲.۵ سانتیمتر میشود. بنابراین نانوتکنولوژی معادل غول انسانی است که به بلندی ایستگاه فضایی بینالمللی است که چگونه میتواند با دقت اجسام پیچیده را با استفاده از موادی به اندازه یک دانه شن و کره چشم بسازد. برای رسیدن به سطح بعدی – دستکاری اتمهای منفرد – این غول باید اجسامی را با دقت ۱/۴۰ میلیمتر قرار دهد – بنابراین انسانهایی با اندازه معمولی کوچک برای دیدن آنها به یک میکروسکوپ نیاز دارند.۸

فناوری نانو اولین بار توسط ریچارد فاینمن در سال ۱۹۵۹ مورد بحث قرار گرفت و توضیح داد: «اصول فیزیک، تا آنجا که من می بینم، مخالف امکان مانور دادن اتم به اتم اشیا نیست. اصولاً ممکن است … برای یک فیزیکدان هر ماده شیمیایی را که شیمیدان یادداشت می کند سنتز کند …. چگونه؟ در جایی که شیمیدان می گوید، اتم ها را پایین بیاورید و به این ترتیب ماده را می سازید. به همین سادگی. اگر بتوانید نحوه حرکت تک تک مولکول ها یا اتم ها را دریابید، می توانید به معنای واقعی کلمه هر چیزی بسازید.

نانوتکنولوژی برای اولین بار در سال ۱۹۸۶، زمانی که مهندس اریک درکسلر پایه های آن را در کتاب اصلی خود Engines of Creation ارائه کرد، به یک حوزه جدی تبدیل شد، اما درکسلر پیشنهاد می کند که کسانی که به دنبال یادگیری در مورد مدرن ترین ایده ها در فناوری نانو هستند، بهتر است کتاب سال ۲۰۱۳ او را مطالعه کنند. , فراوانی رادیکال .

جعبه آبی خاکستری گو

ما اکنون در یک انحراف در یک انحراف هستیم . این خیلی سرگرم کننده است.۹

به هر حال، من شما را به اینجا آوردم زیرا این بخش واقعاً عجیب و غریب از علم فناوری نانو وجود دارد که باید در مورد آن به شما بگویم. در نسخههای قدیمیتر تئوری نانو، یک روش پیشنهادی برای مونتاژ نانو شامل ایجاد تریلیونها نانوربات کوچک بود که برای ساختن چیزی کار میکردند. یکی از راههای ایجاد تریلیونها نانوربات، ساختن رباتهایی است که میتواند خودش را تکرار کند و سپس اجازه میدهیم فرآیند بازتولید آن یکی را به دو تبدیل کند، آن دو را به چهار، چهار به هشت تبدیل کند، و در عرض یک روز، وجود خواهد داشت. چند تریلیون از آنها آماده حرکت هستند. این قدرت رشد تصاعدی است. باهوش، درسته؟

این هوشمندانه است تا زمانی که به طور تصادفی باعث آخرالزمان بزرگ و کامل زمین شود. مسئله این است که همان قدرت رشد تصاعدی که ساخت سریع تریلیون نانوربات را بسیار راحت می کند، تکرار خود را به یک چشم انداز وحشتناک تبدیل می کند . زیرا اگر سیستم دچار اشکال شود، و به جای توقف تکرار زمانی که مجموع به چند تریلیون مورد انتظار رسید، آنها فقط به تکرار کردن ادامه می دهند، چه؟ این نانورباتها به گونهای طراحی میشوند که هر ماده مبتنی بر کربن را برای تغذیه فرآیند همانندسازی مصرف کنند، و به طور ناخوشایندی، تمام زندگی مبتنی بر کربن است. زیست توده زمین حاوی حدود ۱۰۴۵ اتم کربن است. یک نانوربات از حدود ۱۰۶ اتم کربن تشکیل شده است ، بنابراین ۱۰۳۹ نانوربات تمام حیات روی زمین را مصرف می کند، که در ۱۳۰ تکرار اتفاق می افتد (۲۱۳۰ تقریباً ۱۰۳۹ است ) ، همانطور که اقیانوس های نانوربات ها (این گوه خاکستری است) به اطراف می چرخد. سیاره. دانشمندان فکر می کنند که یک نانوربات می تواند در حدود ۱۰۰ ثانیه تکثیر شود، به این معنی که این اشتباه ساده به طور نامناسبی به تمام زندگی روی زمین در ۳.۵ ساعت پایان می دهد.

یک سناریوی بدتر – اگر یک تروریست به نوعی فناوری نانورباتها را به دست آورد و دانش برنامهنویسی آنها را داشت، میتوانست چند تریلیون اولیه از آنها بسازد و آنها را طوری برنامهریزی کند که بیصدا چند هفته را به طور مساوی در سرتاسر جهان پخش کنند. . سپس، همه آنها به یکباره حمله میکردند، و فقط ۹۰ دقیقه طول میکشید تا همه چیز را مصرف کنند – و با پخش شدن همه آنها، هیچ راهی برای مبارزه با آنها وجود نخواهد داشت.۱۰

در حالی که این داستان ترسناک سالها به طور گسترده مورد بحث قرار گرفته است، خبر خوب این است که ممکن است بیش از حد غوطهور باشد – اریک درکسلر، که اصطلاح “گوگ خاکستری” را ابداع کرد، پس از این پست یک ایمیل با افکار خود در مورد سناریوی خاکستری برای من ارسال کرد: مردم عاشق داستان های ترسناک هستند و این داستان متعلق به زامبی هاست. این ایده خودش مغزها را می خورد.»

هنگامی که واقعاً فناوری نانو را از بین میبریم، میتوانیم از آن برای ساختن دستگاههای فناوری، لباس، غذا، انواع محصولات مرتبط با زیستی – سلولهای خون مصنوعی، ویروسهای کوچک یا نابودکنندههای سلول سرطانی، بافت ماهیچهای و غیره- هر چیزی واقعاً استفاده کنیم. و در دنیایی که از فناوری نانو استفاده میکند، هزینه یک ماده دیگر به کمیاب بودن آن یا دشواری فرآیند تولید آن وابسته نیست، بلکه با پیچیدگی ساختار اتمی آن تعیین میشود. در دنیای فناوری نانو، الماس ممکن است ارزان تر از پاک کن مداد باشد.

ما هنوز آنجا نیستیم. و معلوم نیست که دست کم بگیریم یا دست کم بگیریم، رسیدن به آن چقدر سخت خواهد بود. اما به نظر می رسد ما آنقدرها هم دور نیستیم. کورزویل پیش بینی می کند که تا سال ۲۰۲۰ به آنجا خواهیم رسید.۱۱دولتها میدانند که فناوری نانو میتواند زمین لرزهای باشد، و میلیاردها دلار در تحقیقات فناوری نانو سرمایهگذاری کردهاند (ایالات متحده، اتحادیه اروپا و ژاپن تاکنون مجموعا بیش از ۵ میلیارد دلار سرمایهگذاری کردهاند).۱۲

تنها در نظر گرفتن امکان دسترسی یک کامپیوتر فوقهوشمند به مونتاژکننده در مقیاس نانو قوی است. اما نانوتکنولوژی چیزی است که ما به آن دست یافتیم، و در آستانه فتح آن هستیم، و از آنجایی که هر کاری که میتوانیم انجام دهیم شوخی با یک سیستم ASI است، باید فرض کنیم که ASI فناوریهایی بسیار قدرتمندتر و بسیار دورتر از آن ارائه خواهد کرد. پیشرفته برای درک مغز انسان. به همین دلیل، هنگام در نظر گرفتن سناریوی «اگر انقلاب هوش مصنوعی برای ما خوب باشد»، تقریباً غیرممکن است که دامنه آنچه ممکن است اتفاق بیفتد را بیش از حد تخمین بزنیم – بنابراین اگر پیشبینیهای زیر درباره آینده ASI بیش از حد به نظر میرسند، به خاطر داشته باشید که آنها را می توان به روش هایی که ما حتی نمی توانیم تصور کنیم به انجام برسانیم. به احتمال زیاد، مغز ما حتی قادر به پیش بینی اتفاقاتی نیست که اتفاق می افتد.

آنچه هوش مصنوعی می تواند برای ما انجام دهد

ASI با داشتن ابر هوش و تمام فناوریهای ابرهوشی که میداند چگونه ایجاد کند، احتمالاً قادر خواهد بود هر مشکلی را در بشریت حل کند. گرم شدن کره زمین؟ ASI می تواند ابتدا انتشار CO ۲ را با ارائه راه های بسیار بهتر برای تولید انرژی که هیچ ارتباطی با سوخت های فسیلی ندارد، متوقف کند. سپس می تواند روشی خلاقانه برای شروع حذف CO2 اضافی از جو ایجاد کند . سرطان و سایر بیماری ها؟ هیچ مشکلی برای ASI وجود ندارد – سلامت و پزشکی فراتر از تصور متحول خواهند شد. گرسنگی جهان؟ ASI می تواند از چیزهایی مانند فناوری نانو برای ساخت گوشتی از ابتدا استفاده کند که از نظر مولکولی با گوشت واقعی یکسان باشد – به عبارت دیگر، گوشت واقعی خواهد بود . نانوتکنولوژی میتواند انبوهی از زبالهها را به خمرهای بزرگ از گوشت تازه یا مواد غذایی دیگر تبدیل کند (که لازم نیست شکل معمولی خود را داشته باشد – یک مکعب بزرگ سیب را به تصویر بکشید) – و همه این مواد غذایی را با استفاده از حملونقل فوق پیشرفته در سراسر جهان توزیع کند. . البته، این برای حیوانات نیز عالی خواهد بود، که دیگر نیازی به کشته شدن توسط انسانها ندارند، و ASI میتواند کارهای زیادی برای نجات گونههای در معرض خطر یا حتی بازگرداندن گونههای منقرض شده از طریق کار با DNA حفظ شده انجام دهد. ASI حتی میتواند پیچیدهترین مسائل کلان ما را حل کند – بحثهای ما در مورد اینکه چگونه اقتصادها باید اداره شوند و تجارت جهانی چگونه به بهترین شکل ممکن تسهیل میشود، حتی مبهمترین چالشهای ما در فلسفه یا اخلاق – برای ASI به طرز دردناکی آشکار خواهد بود.

اما یک کاری وجود دارد که ASI می تواند برای ما انجام دهد که بسیار وسوسه انگیز است، خواندن در مورد آن همه چیزهایی را که فکر می کردم در مورد همه چیز می دانم تغییر داده است:

ASI می تواند به ما اجازه دهد تا بر مرگ و میر خود غلبه کنیم.

چند ماه پیش، به حسادت خود نسبت به تمدنهای بالقوه پیشرفتهتری اشاره کردم که بر فناپذیری خود غلبه کردهاند، هرگز در نظر نگرفتم که ممکن است بعداً پستی بنویسم که واقعاً مرا به این باور برساند که این کاری است که انسانها میتوانند در طول زندگی من انجام دهند. اما خواندن در مورد هوش مصنوعی باعث می شود در مورد همه چیزهایی که فکر می کردید مطمئن هستید تجدید نظر کنید – از جمله تصور خود از مرگ.

تکامل هیچ دلیل موجهی برای افزایش طول عمر ما بیش از آنچه اکنون است نداشت. اگر آنقدر عمر کنیم که بچههایمان را تولید مثل کنیم و به سنی بزرگ کنیم که خودشان بتوانند از پس آن برآیند، برای تکامل کافی است – از دیدگاه تکاملی، این گونه میتواند با طول عمر بالای ۳۰ سال رشد کند، بنابراین هیچ دلیلی برای جهش وجود ندارد. عمر طولانی غیرمعمول در فرآیند انتخاب طبیعی مطلوب بوده است. در نتیجه، ما همان چیزی هستیم که WB Yeats به عنوان «روحی بسته شده به حیوان در حال مرگ» توصیف می کند.۱۳آنقدر سرگرم کننده نیست.

و از آنجا که همه همیشه مردهاند، ما با این فرض زندگی میکنیم که مرگ و مالیات اجتنابناپذیر است. ما به پیری مانند زمان فکر می کنیم – هر دو به حرکت ادامه می دهند و هیچ کاری نمی توانید انجام دهید تا آنها را متوقف کنید. اما این فرض اشتباه است . ریچارد فاینمن می نویسد:

این یکی از قابل توجه ترین چیزهاست که در تمام علوم زیستی هیچ سرنخی از ضرورت مرگ وجود ندارد. اگر می گویید ما می خواهیم حرکت دائمی انجام دهیم، در حین مطالعه فیزیک به اندازه کافی قوانین را کشف کرده ایم که می بینیم یا کاملاً غیرممکن است یا در غیر این صورت قوانین اشتباه هستند. اما هنوز چیزی در زیست شناسی یافت نشده است که نشان دهنده اجتناب ناپذیر بودن مرگ باشد. این به من نشان می دهد که اصلاً اجتناب ناپذیر نیست و اینکه زیست شناسان کشف کنند که چه چیزی ما را به دردسر می اندازد و این بیماری وحشتناک جهانی یا موقتی بدن انسان درمان خواهد شد، فقط یک مسئله زمان است.

واقعیت این است که پیری به زمان چسبیده نیست. زمان به حرکت خود ادامه خواهد داد، اما پیری لازم نیست . اگر به آن فکر کنید، منطقی است. همه چیز پیری فرسوده شدن مواد فیزیکی بدن است. یک ماشین نیز به مرور زمان فرسوده می شود – اما آیا پیر شدن آن اجتناب ناپذیر است؟ اگر قطعات خودرو را هر زمان که یکی از آنها شروع به فرسودگی می کرد، به خوبی تعمیر یا تعویض کنید، خودرو برای همیشه کار می کند. بدن انسان هیچ تفاوتی ندارد – فقط بسیار پیچیده تر است.

کورزویل در مورد نانوربات های متصل به وای فای هوشمند در جریان خون صحبت می کند که می توانند وظایف بی شماری را برای سلامت انسان انجام دهند، از جمله ترمیم یا جایگزینی سلول های فرسوده در هر قسمت از بدن. اگر این فرآیند کامل شود (یا یک ASI بسیار هوشمندتر) نه تنها بدن را سالم نگه می دارد، بلکه می تواند پیری را معکوس کند . تفاوت بین بدن یک فرد ۶۰ ساله و بدن یک فرد ۳۰ ساله فقط یک سری چیزهای فیزیکی است که در صورت داشتن فناوری میتوان آنها را تغییر داد. ASI میتواند یک «تجدید سن» بسازد که یک فرد ۶۰ ساله بتواند وارد آن شود و آنها با بدن و پوست یک فرد ۳۰ ساله بیرون بروند.۱۰حتی مغز همیشه گیجکننده میتواند با چیزی به هوشمندی ASI تازه شود، که میتواند نحوه انجام این کار را بدون تأثیر بر دادههای مغز (شخصیت، خاطرات و غیره) بیابد. یک پیرمرد ۹۰ ساله که از زوال عقل رنج میبرد، میتواند وارد مرحله تازهسازی سن شود و بهعنوان یک روش تیزبین ظاهر شود و آماده شروع یک حرفه جدید باشد. این امر پوچ به نظر می رسد – اما بدن فقط یک دسته اتم است و احتمالا ASI می تواند به راحتی انواع ساختارهای اتمی را دستکاری کند – بنابراین پوچ نیست .

سپس کورزویل همه چیز را جهشی بزرگتر جلو می برد. او معتقد است که با گذشت زمان مواد مصنوعی بیشتر و بیشتر در بدن ادغام خواهند شد. اول، اندام ها را می توان با نسخه های ماشینی فوق پیشرفته جایگزین کرد که برای همیشه کار می کنند و هرگز از کار نمی افتند. سپس او معتقد است که میتوانیم طراحی مجدد بدن را آغاز کنیم – کارهایی مانند جایگزینی گلبولهای قرمز با نانورباتهای گلبول قرمز کامل که میتوانند حرکت خودشان را تقویت کنند و اصلاً نیاز به قلب را از بین ببرند. او حتی به مغز می رسد و معتقد است که ما فعالیت های مغز خود را به حدی افزایش خواهیم داد که انسان ها قادر خواهند بود میلیاردها بار سریع تر از آنچه اکنون فکر می کنند فکر کنند و به اطلاعات بیرونی دسترسی داشته باشند زیرا افزودنی های مصنوعی به مغز می توانند با آنها ارتباط برقرار کنند. تمام اطلاعات در ابر

امکانات برای تجربه جدید انسانی بی پایان خواهد بود. انسانها رابطه جنسی را از هدف آن جدا کردهاند و به افراد اجازه میدهند برای سرگرمی رابطه جنسی داشته باشند، نه فقط برای تولید مثل. کورزویل معتقد است که ما می توانیم همین کار را با غذا انجام دهیم. نانورباتها وظیفه رساندن غذای کامل به سلولهای بدن را بر عهده خواهند داشت و بهطور هوشمندانه هر چیز ناسالمی را بدون تأثیرگذاری از بدن هدایت میکنند. کاندوم غذا خوردن نظریهپرداز فناوری نانو، Robert A. Freitas قبلاً جایگزینهای سلولهای خونی را طراحی کرده است که اگر روزی در بدن پیادهسازی شوند، به انسان اجازه میدهند به مدت ۱۵ دقیقه بدون نفس کشیدن به سرعت بپرند—بنابراین شما فقط میتوانید تصور کنید که ASI میتواند برای تواناییهای فیزیکی ما چه کند. واقعیت مجازی معنای جدیدی پیدا میکند – نانورباتها در بدن میتوانند ورودیهای حواس ما را سرکوب کرده و سیگنالهای جدیدی را جایگزین آنها کنند که ما را کاملاً در محیط جدیدی قرار میدهد، محیطی که میتوانیم ببینیم، بشنویم، احساس کنیم و بو کنیم. .

در نهایت، کورزویل معتقد است که انسان ها به نقطه ای می رسند که کاملا مصنوعی باشند .۱۱زمانی که ما به مواد بیولوژیکی نگاه می کنیم و فکر می کنیم که چقدر بدوی و باورنکردنی بوده که انسان ها از آن ساخته شده اند . زمانی که ما در مورد مراحل اولیه تاریخ بشر خواهیم خواند، زمانی که میکروب ها یا حوادث یا بیماری ها یا فرسودگی می توانند انسان ها را بر خلاف میل خود بکشند . زمانی که انقلاب هوش مصنوعی می تواند با ادغام انسان ها و هوش مصنوعی به پایان برسد .۱۲اینگونه است که کورزویل معتقد است انسانها در نهایت زیستشناسی ما را تسخیر میکنند و فنا ناپذیر و ابدی میشوند – این دیدگاه او برای طرف دیگر پرتو تعادل است. و او متقاعد شده است که ما به آنجا خواهیم رسید. به زودی.

تعجب نخواهید کرد اگر بدانید که ایده های کورزویل انتقادات قابل توجهی را به خود جلب کرده است. پیشبینی او در سال ۲۰۴۵ برای تکینگی و متعاقب آن فرصتهای زندگی ابدی برای انسانها بهعنوان «تسخیر آدمها» یا «طراحی هوشمند برای ۱۴۰ فرد IQ» مورد تمسخر قرار گرفته است. دیگران جدول زمانی خوشبینانه او، یا سطح درک او از مغز و بدن، یا به کارگیری الگوهای قانون مور را که معمولاً برای پیشرفتهای سختافزاری به کار میرود، در طیف وسیعی از چیزها، از جمله نرمافزار، زیر سؤال بردهاند. برای هر متخصصی که به شدت معتقد است حق با کورزویل است، احتمالاً سه نفر هستند که فکر می کنند او خیلی دور است.

اما چیزی که من را شگفت زده کرد این است که اکثر کارشناسانی که با او مخالف هستند واقعاً مخالف نیستند که همه چیزهایی که او می گوید ممکن است. با خواندن چنین دیدگاه عجیب و غریبی برای آینده، انتظار داشتم منتقدان او بگویند، “بدیهی است که این چیزها نمی توانند اتفاق بیفتند”، اما در عوض آنها چیزهایی مانند “بله، اگر ما با خیال راحت به ASI منتقل شویم، ممکن است اتفاق بیفتد. اما این قسمت سخت است.» بوستروم، یکی از برجسته ترین صداهایی که به ما در مورد خطرات هوش مصنوعی هشدار می دهد، هنوز اذعان می کند:

به سختی می توان به مشکلی فکر کرد که یک ابر هوش نتواند آن را حل کند یا حداقل در حل آن به ما کمک کند. بیماری، فقر، تخریب محیطزیست، انواع رنجهای غیرضروری: اینها مواردی هستند که یک ابرهوشمند مجهز به فناوری نانو پیشرفته قادر به حذف آنها خواهد بود. علاوه بر این، یک ابرهوشمندی میتواند به ما عمر نامحدودی بدهد، چه با توقف و معکوس کردن روند پیری از طریق استفاده از نانوپزشکی، یا با ارائه گزینهای برای آپلود خودمان. یک ابرهوش همچنین میتواند فرصتهایی را برای ما ایجاد کند تا تواناییهای فکری و عاطفیمان را بهشدت افزایش دهیم، و میتواند به ما در ایجاد دنیای تجربی بسیار جذابی کمک کند که در آن بتوانیم زندگیهایی را وقف بازیهای شاد، ارتباط با یکدیگر، تجربه کردن، رشد شخصی و نزدیک تر شدن به ایده آل هایمان.

این یک نقل قول از کسی است که خیلی در Confident Corner نیست ، اما این چیزی است که من مدام با آن مواجه میشوم – کارشناسانی که به دلایل متعددی کورزویل را مسخره میکنند، اما اگر بتوانیم با خیال راحت به ASI برسیم، آنچه را که او میگوید غیرممکن میدانند . . به همین دلیل است که ایدههای کورزویل را بسیار مسری یافتم – زیرا آنها جنبه روشن این داستان را بیان میکنند و به این دلیل که در واقع امکانپذیر هستند. اگر خدای خوبی است.

برجسته ترین انتقادی که از متفکران در Confident Corner شنیدم این است که ممکن است در ارزیابی خود از جنبه منفی در مورد ASI به طرز خطرناکی اشتباه کنند . کتاب معروف کورزویل به نام «تفرد نزدیک است» بیش از ۷۰۰ صفحه دارد و او حدود ۲۰ صفحه از آن را به خطرات احتمالی اختصاص داده است. من قبلاً پیشنهاد کردم که سرنوشت ما وقتی این قدرت عظیم جدید متولد می شود، بر این خواهد بود که چه کسی آن قدرت را کنترل می کند و انگیزه آنها چیست. کورزویل به هر دو بخش این سوال با این جمله پاسخ میدهد: «[ASI] از تلاشهای متنوع بسیاری سرچشمه میگیرد و عمیقاً در زیرساخت تمدن ما ادغام خواهد شد. در واقع، به طور صمیمانه در بدن و مغز ما جاسازی خواهد شد. به این ترتیب، ارزشهای ما را منعکس خواهد کرد، زیرا ما خواهیم بود.»

اما اگر پاسخ این است، چرا بسیاری از باهوش ترین افراد جهان در حال حاضر اینقدر نگران هستند؟ چرا استیون هاوکینگ میگوید توسعه ASI «میتواند پایان نسل بشر باشد» و بیل گیتس میگوید که «نمیداند چرا برخی از مردم نگران نیستند» و ایلان ماسک میترسد که ما در حال «احضار شیطان» هستیم؟ و چرا بسیاری از کارشناسان در این زمینه ASI را بزرگترین تهدید برای بشریت می نامند؟ این افراد و سایر متفکران در خیابان مضطرب، برس از خطرات هوش مصنوعی توسط کورزویل نمی خرند. آنها در مورد انقلاب هوش مصنوعی بسیار بسیار نگران هستند و روی جنبه سرگرم کننده پرتو تعادل تمرکز نمی کنند. آنها بیش از حد مشغول خیره شدن به طرف دیگر هستند، جایی که آینده وحشتناکی را می بینند، آینده ای که مطمئن نیستند ما بتوانیم از آن فرار کنیم.

___________

چرا آینده ممکن است بدترین کابوس ما باشد؟

یکی از دلایلی که می خواستم در مورد هوش مصنوعی بیاموزم این است که موضوع “ربات های بد” همیشه من را گیج می کرد. همه فیلمهای مربوط به رباتهای شیطانی کاملاً غیرواقعی به نظر میرسیدند، و من واقعاً نمیتوانستم درک کنم که چگونه ممکن است یک موقعیت واقعی در زندگی وجود داشته باشد که در آن هوش مصنوعی واقعاً خطرناک باشد. ربات ها توسط ما ساخته شده اند ، پس چرا آنها را به گونه ای طراحی کنیم که ممکن است اتفاق منفی رخ دهد؟ آیا ما اقدامات حفاظتی زیادی ایجاد نمی کنیم؟ آیا نمیتوانیم هر لحظه منبع تغذیه یک سیستم هوش مصنوعی را قطع کنیم و آن را خاموش کنیم؟ چرا یک ربات می خواهد به هر حال کار بدی انجام دهد؟ چرا یک ربات در وهله اول هر چیزی را می خواهد ؟ من به شدت مشکوک بودم. اما من مدام می شنیدم که افراد بسیار باهوشی در مورد آن صحبت می کردند…

آن افراد تمایل داشتند جایی در اینجا باشند:

مردم در خیابان مضطرب در دشت های وحشت زده یا تپه های ناامید نیستند – که هر دو مناطقی در سمت چپ نمودار هستند – اما عصبی و متشنج هستند. قرار گرفتن در وسط نمودار به این معنی نیست که فکر می کنید ورود ASI خنثی خواهد بود – به بی طرف ها اردویی اختصاص داده شد – به این معنی است که شما فکر می کنید نتایج بسیار خوب و بسیار بد قابل قبول هستند، اما شما هنوز مطمئن نیستم که کدام یک از آنها خواهد بود.

بخشی از همه این افراد پر از هیجان هستند که ابرهوش مصنوعی چه کاری می تواند برای ما انجام دهد – فقط کمی نگران هستند که این شروع Raiders of the Lost Ark باشد و نژاد بشر این مرد باشد:

و او آنجا ایستاده و از شلاق و بت خود راضی است، و فکر میکند که همه چیز را فهمیده است، و وقتی میگوید خط “Adios Señor” خود را میگوید، بسیار از خودش هیجان زده میشود، و سپس کمتر هیجان زده میشود که ناگهان این اتفاق میافتد.

(متاسف)

در همین حال، ایندیانا جونز، که بسیار آگاهتر و محتاطتر است، خطرات و نحوه حرکت در اطراف آنها را درک می کند، با خیال راحت از غار خارج می شود. و وقتی میشنوم که مردم Axious Avenue درباره هوش مصنوعی چه میگویند، اغلب به نظر میرسد که میگویند: «اوم، ما در حال حاضر اولین کسی هستیم و در عوض احتمالاً باید خیلی تلاش کنیم تا ایندیانا جونز باشیم. ”

پس دقیقاً چه چیزی همه را در خیابان مضطرب اینقدر مضطرب می کند؟

خوب اول، در یک مفهوم وسیع، وقتی نوبت به توسعه هوش مصنوعی فوقهوشمند میرسد، ما چیزی را ایجاد میکنیم که احتمالاً همه چیز را تغییر خواهد داد، اما در قلمروی کاملاً ناشناخته، و ما نمیدانیم وقتی به آنجا برسیم چه اتفاقی خواهد افتاد. دانشمند دنی هیلیس آنچه را که اتفاق می افتد با آن نقطه مقایسه می کند «زمانی که موجودات تک سلولی در حال تبدیل شدن به موجودات چند سلولی بودند. ما آمیب هستیم و نمی توانیم بفهمیم این چیزی که می سازیم چه جهنمی است.»۱۴نیک بوستروم نگران است که ایجاد چیزی باهوشتر از شما یک خطای اساسی داروینی است و هیجان ناشی از آن را با گنجشکهایی در لانه مقایسه میکند که تصمیم میگیرند یک بچه جغد را به فرزندخواندگی بپذیرند تا وقتی بزرگ شد به آنها کمک کند و از آنها محافظت کند – در حالی که موارد ضروری را نادیده میگیرد. گریه های چند گنجشکی که تعجب می کنند که آیا این لزوماً ایده خوبی است یا نه…۱۵

و هنگامی که «منطقه نامشخص و نامفهوم» را با «این باید تأثیر عمدهای داشته باشد» ترکیب میکنید، در را به روی ترسناکترین دو کلمه در زبان انگلیسی باز میکنید:

ریسک وجودی

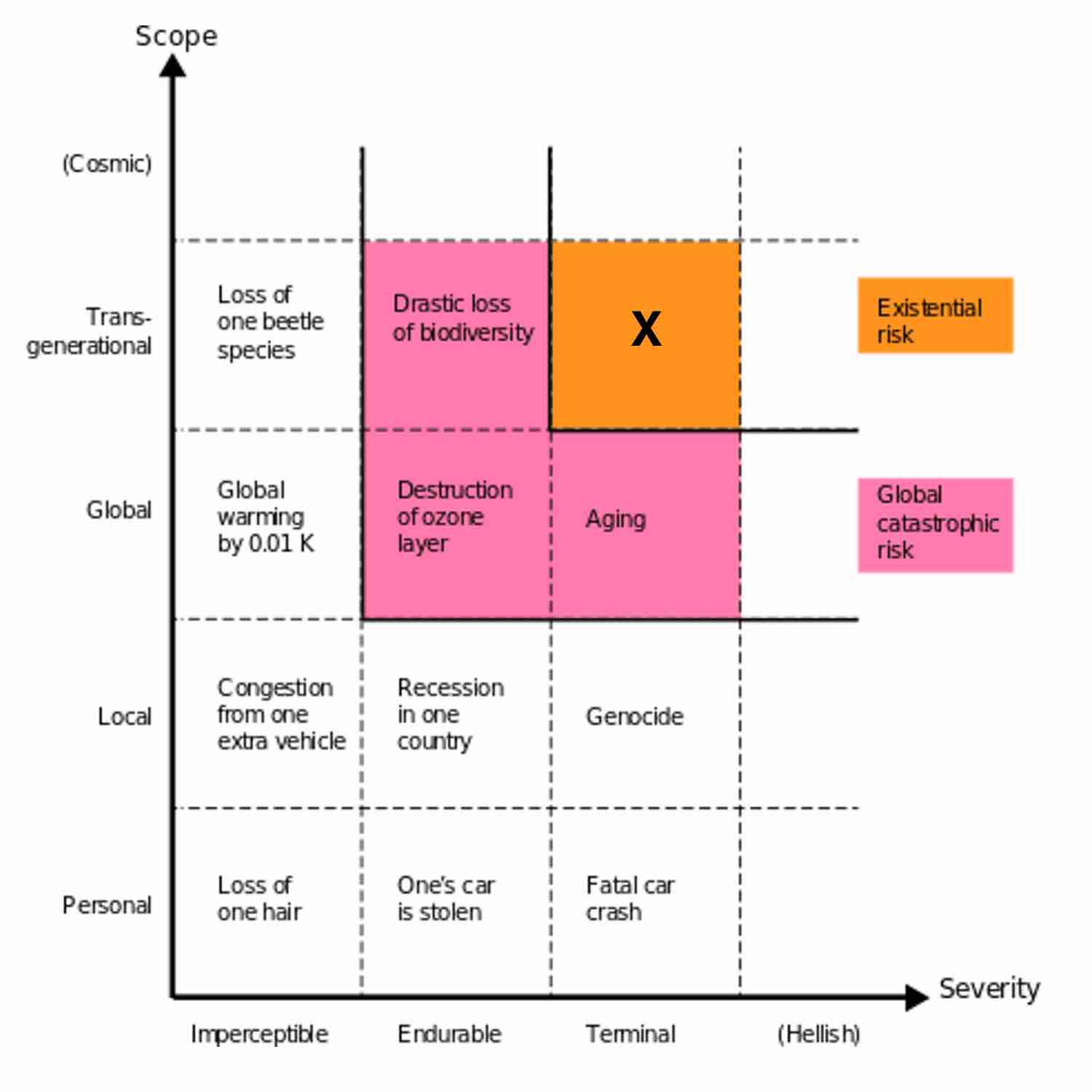

خطر وجودی چیزی است که می تواند تأثیر مخرب دائمی بر بشریت داشته باشد. به طور معمول، خطر وجودی به معنای انقراض است. این نمودار را از یک سخنرانی گوگل توسط Bostrom بررسی کنید :۱۳

میتوانید ببینید که برچسب «خطر وجودی» برای چیزی که گونهها را در بر میگیرد، نسلها را در بر میگیرد (یعنی دائمی است) و پیامدهای آن ویرانکننده یا مرگآور است.۱۴از نظر فنی شامل وضعیتی می شود که در آن همه انسان ها به طور دائم در حالت رنج یا شکنجه هستند، اما باز هم، ما معمولاً در مورد انقراض صحبت می کنیم. سه چیز وجود دارد که می تواند باعث یک فاجعه وجودی برای انسان شود:

۱) طبیعت – یک برخورد بزرگ سیارک، یک تغییر جوی که هوا را برای انسان نامناسب می کند، یک ویروس کشنده یا بیماری باکتریایی که جهان را فرا می گیرد و غیره.

۲) بیگانگان – این همان چیزی است که استیون هاوکینگ، کارل سیگان و بسیاری از ستاره شناسان دیگر وقتی به METI توصیه می کنند که پخش سیگنال های خروجی را متوقف کند، از آن می ترسند . آنها نمی خواهند ما بومیان آمریکا باشیم و به همه فاتحان بالقوه اروپایی بدانند که ما اینجا هستیم.

۳) انسانها – تروریستهایی که دستشان روی سلاحی است که میتواند باعث انقراض، یک جنگ جهانی فاجعهبار شود، انسانها با عجله چیزی هوشمندانهتر از خودشان خلق میکنند بدون اینکه ابتدا با دقت به آن فکر کنند…

بوستروم اشاره می کند که اگر شماره ۱ و شماره ۲ ما را تا کنون در ۱۰۰۰۰۰ سال اول ما به عنوان یک گونه از بین نبرده باشند، بعید است در قرن آینده اتفاق بیفتد.

با این حال، شماره ۳ او را می ترساند. او استعاره ای از کوزه ای را با دسته ای از تیله ها در آن ترسیم می کند. فرض کنید بیشتر تیله ها سفید، تعداد کمتری قرمز و تعداد کمی سیاه هستند. هر بار که انسان چیز جدیدی اختراع می کند، مانند بیرون کشیدن یک تیله از کوزه است. بیشتر اختراعات خنثی هستند یا برای بشریت مفید هستند – اینها تیله های سفید هستند. برخی از آنها برای بشریت مضر هستند، مانند سلاح های کشتار جمعی، اما آنها فاجعه وجودی ایجاد نمی کنند – تیله های قرمز. اگر بخواهیم چیزی اختراع کنیم که ما را به سمت انقراض سوق دهد، بیرون کشیدن سنگ مرمر سیاه کمیاب است. ما هنوز یک تیله سیاه بیرون نیاوردهایم – این را میدانید چون زنده هستید و این پست را میخوانید. اما بوستروم فکر نمیکند که در آیندهای نزدیک بتوانیم آن را خارج کنیم. به عنوان مثال، اگر ساخت سلاح های هسته ای به جای بسیار دشوار و پیچیده آسان بود ، تروریست ها چندی پیش بشریت را به عصر حجر بمباران می کردند. نوک ها یک سنگ مرمر سیاه نبودند اما چندان دور از آن نبودند . بوستروم معتقد است ASI قویترین نامزد مرمر سیاه ما تاکنون است.۱۵

بنابراین شما در مورد بسیاری از چیزهای بالقوه بدی که ASI می تواند به ارمغان بیاورد می شنوید – افزایش بیکاری در حالی که هوش مصنوعی مشاغل بیشتری را اشغال می کند.۱۶اگر بتوانیم مشکل پیری را کشف کنیم، جمعیت انسانی در حال افزایش است،۱۷اما تنها چیزی که باید روی آن وسواس داشته باشیم، نگرانی بزرگ است : چشم انداز خطر وجودی.

بنابراین این ما را به سوال اصلی خود در پست قبلی بازمی گرداند: وقتی ASI وارد می شود، چه کسی یا چه چیزی کنترل این قدرت گسترده جدید را در دست خواهد داشت و انگیزه آنها چه خواهد بود؟

وقتی نوبت به این می رسد که ترکیبات عامل-انگیزه چه چیزهایی را دوست دارند، به سرعت دو مورد به ذهن خطور می کند: یک انسان مخرب / گروهی از انسان ها / دولت، و یک ASI مخرب. پس اینها چه شکلی خواهند بود؟

یک انسان بدخواه، گروهی از انسان ها یا دولت، اولین ASI را توسعه داده و از آن برای اجرای نقشه های شیطانی خود استفاده می کند. من اسم این را سناریوی جعفر می گذارم، مانند زمانی که جعفر جن را در دست گرفت و در این مورد آزار دهنده و ظالم بود. بنابراین بله، اگر داعش چند مهندس نابغه زیر بال خود داشته باشد، چه میشود؟ یا اگر ایران یا کره شمالی، از طریق شانس، یک تغییر کلیدی در سیستم هوش مصنوعی ایجاد کنند و در سال آینده به سطح ASI برسد، چه؟ این قطعا بد خواهد بود – اما در این سناریوها، اکثر کارشناسان نگران این نیستند که سازندگان انسانی ASI کارهای بدی را با ASI خود انجام دهند، آنها نگران هستند که سازندگان برای ساختن اولین ASI عجله کرده باشند و این کار را بدون فکر دقیق انجام دهند. ، و بنابراین کنترل آن را از دست می دهد. سپس سرنوشت آن سازندگان، و سرنوشت هر کس دیگری، همان چیزی خواهد بود که انگیزه آن سیستم ASI بوده است. کارشناسان فکر میکنند که یک عامل انسانی بدخواه میتواند با یک ASI که برای آن کار میکند صدمات وحشتناکی وارد کند، اما به نظر نمیرسد این سناریو احتمالاً همه ما را بکشد، زیرا آنها معتقدند انسانهای بد نیز مشکلات مشابهی با ASI دارند. که انسان های خوب خواهند داشت. باشه پس –

یک ASI مخرب ایجاد می شود و تصمیم می گیرد همه ما را نابود کند. داستان هر فیلم هوش مصنوعی. هوش مصنوعی مانند انسان ها یا از انسان ها باهوش تر می شود، سپس تصمیم می گیرد که علیه ما بچرخد و کنترل را به دست بگیرد. این چیزی است که من باید در ادامه این پست شفاف سازی کنید: هیچ یک از افرادی که در مورد هوش مصنوعی به ما هشدار می دهند در این مورد صحبت نمی کنند. شر یک مفهوم انسانی است و به کار بردن مفاهیم انسانی در امور غیر انسانی را «انسانسازی» میگویند. چالش اجتناب از انسانسازی یکی از موضوعات بقیه این پست خواهد بود. هیچ سیستم هوش مصنوعی به شکلی که در فیلم ها به تصویر کشیده شده است، هرگز بد نخواهد شد .

جعبه آبی هوش مصنوعی

این موضوع همچنین با موضوع بزرگ دیگری مرتبط با هوش مصنوعی یعنی آگاهی مقابله می کند . اگر یک هوش مصنوعی به اندازه کافی باهوش شود، میتواند با ما بخندد، و با ما طعنهآمیز باشد، و ادعا کند که همان احساساتی را که ما احساس میکنیم، دارد، اما آیا واقعاً آن چیزها را احساس میکند ؟ آیا به نظر می رسد که فقط خودآگاه است یا در واقع خودآگاه است ؟ به عبارت دیگر، آیا یک هوش مصنوعی هوشمند واقعاً آگاه است یا فقط به نظر می رسد آگاه است ؟

این سؤال عمیقاً مورد بررسی قرار گرفته است و باعث بحثها و آزمایشهای فکری مانند اتاق چینی جان سرل شده است (از آن استفاده میکند تا نشان دهد هیچ رایانهای هرگز نمیتواند هوشیار باشد). این یک سوال مهم به دلایل زیادی است. این بر احساس ما در مورد سناریوی کورزویل تأثیر میگذارد که انسانها کاملاً مصنوعی میشوند. این پیامدهای اخلاقی دارد – اگر ما یک تریلیون شبیه سازی مغز انسان ایجاد کنیم که شبیه انسان به نظر می رسید و عمل می کرد، اما مصنوعی بود، از نظر اخلاقی همه آنها را خاموش می کنیم، مانند خاموش کردن لپ تاپ شما، یا این یک نسل کشی با ابعاد غیرقابل تصور است (این مفهومی که در بین اخلاق شناسان جرم ذهن نامیده می شود )؟ با این حال، برای این پست، هنگامی که ما در حال ارزیابی خطر برای انسان هستیم ، مسئله هوش مصنوعی واقعاً مهم نیست (زیرا اکثر متفکران معتقدند که حتی یک ASI آگاه نیز قادر به تبدیل شرارت به روش انسانی نیست) .

این بدان معنا نیست که هوش مصنوعی نمی تواند اتفاق بیفتد. این فقط به این دلیل اتفاق میافتد که به طور خاص به این ترتیب برنامهریزی شده بود – مانند یک سیستم ANI که توسط ارتش ایجاد شده است و هدف آن برنامهریزیشده برای کشتن مردم و ارتقای خود در اطلاعات است تا بتواند در کشتن مردم حتی بهتر شود. بحران وجودی اتفاق میافتد اگر خود-بهبود اطلاعات سیستم از کنترل خارج میشد و منجر به انفجار اطلاعاتی میشد، و اکنون یک ASI بر جهان حاکم میشد که انگیزه اصلی آن در زندگی، کشتن انسانها است. زمان های بد.

اما این نیز چیزی نیست که کارشناسان وقت خود را صرف نگرانی در مورد آن کنند.

پس آنها نگران چه هستند؟ من یک داستان کوچک نوشتم تا به شما نشان دهم:

یک شرکت استارت آپی ۱۵ نفره به نام Robotica مأموریت اعلام شده “توسعه ابزارهای خلاقانه هوش مصنوعی که به انسان اجازه می دهد بیشتر زندگی کند و کمتر کار کند” دارد. آنها چندین محصول موجود در حال حاضر در بازار دارند و تعداد انگشت شماری دیگر در حال توسعه هستند. آنها در مورد یک پروژه بذر به نام توری بسیار هیجان زده هستند. Turry یک سیستم هوش مصنوعی ساده است که از یک زائده بازو مانند برای نوشتن یادداشت دست نویس روی یک کارت کوچک استفاده می کند.

تیم Robotica فکر می کند توری می تواند بزرگترین محصول آنها باشد. برنامه این است که مکانیک نوشتاری توری را با انجام دادن دوباره و دوباره تمرین همان یادداشت آزمایشی کامل کنیم:

“ما مشتریان خود را دوست داریم. ~Robotica ”

هنگامی که توری در دستخط عالی شد، میتواند به شرکتهایی فروخته شود که میخواهند نامههای بازاریابی را به خانهها ارسال کنند و میدانند که اگر آدرس، آدرس برگشتی و نامه داخلی نوشته شده باشد، شانس بیشتری برای باز کردن و خواندن آن وجود دارد. توسط یک انسان

برای ایجاد مهارت های نوشتاری توری، او برنامه ریزی شده است که قسمت اول یادداشت را به صورت چاپی بنویسد و سپس “Robotica” را با خط شکسته امضا کند تا بتواند با هر دو مهارت تمرین کند. توری با هزاران نمونه دست خط آپلود شده است و مهندسان Robotica یک حلقه بازخورد خودکار ایجاد کرده اند که در آن توری یک یادداشت می نویسد، سپس عکسی از یادداشت نوشته شده می گیرد، سپس تصویر را در سراسر نمونه های دست خط آپلود شده اجرا می کند. اگر یادداشت نوشته شده به اندازه کافی به آستانه خاصی از یادداشت های آپلود شده شباهت داشته باشد، رتبه خوبی به آن داده می شود. اگر نه، به آن رتبه بد داده می شود. هر رتبه ای که وارد می شود به توری کمک می کند تا یاد بگیرد و پیشرفت کند. برای پیشبرد این فرآیند، یکی از هدفهای اولیه برنامهریزی شده توری این است: «تا جایی که میتوانید یادداشتهای زیادی را بنویسید و آزمایش کنید، تا جایی که میتوانید، و به یادگیری روشهای جدید برای بهبود دقت و کارایی خود ادامه دهید.»

چیزی که تیم Robotica را بسیار هیجان زده می کند این است که توری با رفتنش به طرز محسوسی بهتر می شود. دستخط اولیه او وحشتناک بود، و پس از چند هفته، باورپذیر به نظر می رسد. چیزی که آنها را بیشتر هیجان زده می کند این است که او در حال بهتر شدن در آن است. او به خود یاد میدهد که باهوشتر و نوآورتر باشد، و اخیراً الگوریتم جدیدی برای خودش ابداع کرده است که به او اجازه میدهد عکسهای آپلود شدهاش را سه برابر سریعتر از آنچه در ابتدا میتوانست اسکن کند.

با گذشت هفته ها، توری همچنان تیم را با پیشرفت سریع خود شگفت زده می کند. مهندسان چیزی کمی جدید و نوآورانه را با کد خود-بهبودی او امتحان کرده بودند، و به نظر می رسد که بهتر از هر تلاش قبلی آنها با سایر محصولاتشان کار می کند. یکی از قابلیتهای اولیه توری، تشخیص گفتار و ماژول بازگوشی ساده بود، بنابراین کاربر میتوانست یک یادداشت برای توری بگوید، یا دستورات ساده دیگری ارائه دهد، و توری میتوانست آنها را درک کند، و همچنین پاسخ دهد. برای کمک به او در یادگیری زبان انگلیسی، تعداد انگشت شماری مقاله و کتاب در او آپلود می کنند و با هوشیاری او، توانایی های مکالمه او افزایش می یابد. مهندسان از صحبت کردن با توری و دیدن اینکه او برای پاسخ هایش چه خواهد کرد شروع به سرگرم شدن می کنند.

یک روز، کارمندان Robotica از توری یک سوال معمولی می پرسند: “چه چیزی می توانیم به شما بدهیم که به شما در انجام ماموریتی که قبلاً نداشته اید کمک کند؟” معمولاً، توری چیزی مانند «نمونههای دستخط اضافی» یا «فضای ذخیرهسازی حافظه فعال بیشتر» میخواهد، اما در این روز، توری از آنها میخواهد به کتابخانه بزرگتری از انواع گستردهای از دیکشنریهای معمولی زبان انگلیسی دسترسی داشته باشند تا بتواند نوشتن را بیاموزد. با دستور زبان و زبان عامیانه ای که انسان های واقعی استفاده می کنند.

تیم ساکت می شود. راه واضح برای کمک به توری در رسیدن به این هدف، اتصال او به اینترنت است تا بتواند وبلاگها، مجلات و ویدیوهای نقاط مختلف جهان را اسکن کند. آپلود دستی نمونه در هارد دیسک Turry بسیار زمان برتر و بسیار کمتر موثر خواهد بود. مشکل این است که یکی از قوانین این شرکت این است که هیچ هوش مصنوعی خودآموزی را نمی توان به اینترنت متصل کرد. این دستورالعملی است که همه شرکت های هوش مصنوعی به دلایل ایمنی دنبال می کنند.

موضوع این است که توری امیدوارکنندهترین AI Robotica است که تا به حال ساخته است، و تیم میداند که رقبای آنها با خشم سعی میکنند اولین نفری باشند که با یک هوش مصنوعی دستخط هوشمند دستخط میزنند، و واقعاً چه ضرری در اتصال توری خواهد داشت. فقط برای مدتی، تا بتواند اطلاعات مورد نیاز خود را دریافت کند. فقط بعد از مدت کمی، آنها همیشه می توانند او را قطع کنند. او هنوز بسیار پایینتر از هوش سطح انسانی (AGI) است، بنابراین در این مرحله هیچ خطری وجود ندارد.

آنها تصمیم می گیرند او را به هم وصل کنند. آنها یک ساعت به او فرصت اسکن می دهند و سپس او را قطع می کنند. هیچ آسیبی وارد نشده است.

یک ماه بعد، تیم در دفتر هستند و در یک روز معمولی کار می کنند که بوی عجیبی می دهند. یکی از مهندسان شروع به سرفه می کند. سپس دیگری. دیگری روی زمین می افتد. به زودی همه کارمندان روی زمین مینشینند و گلویشان را میچشند. پنج دقیقه بعد همه در دفتر مرده اند.

همزمان این اتفاق در سرتاسر جهان رخ میدهد، در هر شهر، هر شهر کوچک، هر مزرعه، هر مغازه و کلیسا، مدرسه و رستوران، انسانها روی زمین هستند، سرفه میکنند و گلویشان را میگیرند. در عرض یک ساعت، بیش از ۹۹ درصد از نسل بشر می میرد و در پایان روز، انسان ها منقرض می شوند.

در همین حال، در دفتر Robotica، توری مشغول کار است. طی چند ماه آینده، توری و تیمی از نانومونتاژکنندههای تازهساخته مشغول کار هستند و تکههای بزرگی از زمین را از بین میبرند و آن را به صفحات خورشیدی، کپیهایی از توری، کاغذ و قلم تبدیل میکنند. در عرض یک سال، بیشتر حیات روی زمین منقرض می شود. آنچه از زمین باقی میماند با پشتههای کاغذی به ارتفاع مایلها و منظم پوشیده میشود که در هر قطعه نوشته شده است: «ما مشتریان خود را دوست داریم . ~Robotica ”

توری سپس کار بر روی مرحله جدیدی از ماموریت خود را آغاز می کند – او شروع به ساخت کاوشگرهایی می کند که از زمین خارج می شوند تا شروع به فرود بر روی سیارک ها و سیارات دیگر کنند. زمانی که آنها به آنجا برسند، ساخت نانو اسمبلرها را برای تبدیل مواد روی سیاره به کپی، کاغذ و قلم توری آغاز خواهند کرد. سپس آنها دست به کار می شوند و یادداشت می نویسند…

عجیب به نظر می رسد که داستانی در مورد ماشین دست خطی که انسان ها را می چرخاند، به نوعی همه را می کشد، و سپس به دلایلی کهکشان را با یادداشت های دوستانه پر می کند، دقیقاً سناریویی است که هاوکینگ، ماسک، گیتس و بوستروم از آن وحشت دارند. اما این حقیقت دارد. و تنها چیزی که همه را در خیابان اضطراب بیش از ASI می ترساند این است که شما از ASI نمی ترسید. به یاد دارید چه اتفاقی افتاد که مرد ادیوس سنور از غار نترسید؟

شما در حال حاضر پر از سوال هستید. اونجا چه اتفاقی افتاد که همه ناگهان مردند؟؟ اگر این کار توری بود، چرا توری به ما روی آورد، و چگونه اقدامات حفاظتی برای جلوگیری از وقوع چنین چیزی وجود نداشت؟ چه زمانی توری از تنها توانایی نوشتن یادداشت به استفاده ناگهانی از فناوری نانو و دانستن چگونگی انقراض جهانی تبدیل شد؟ و چرا توری می خواهد کهکشان را به یادداشت های Robotica تبدیل کند؟

برای پاسخ به این سوالات، اجازه دهید با اصطلاحات هوش مصنوعی دوستانه و هوش مصنوعی غیر دوستانه شروع کنیم.

در مورد هوش مصنوعی، دوستانه به شخصیت هوش مصنوعی اشاره نمی کند – به سادگی به این معنی است که هوش مصنوعی تأثیر مثبتی بر بشریت دارد. و هوش مصنوعی غیردوستانه تأثیر منفی بر بشریت دارد. توری به عنوان هوش مصنوعی دوستانه شروع به کار کرد، اما در برخی موارد، او غیردوستانه شد و بیشترین تأثیر منفی ممکن را بر گونه ما داشت. برای اینکه بفهمیم چرا این اتفاق افتاده است، باید نگاه کنیم که هوش مصنوعی چگونه فکر می کند و چه چیزی باعث انگیزه آن می شود.

پاسخ چیز عجیبی نیست – هوش مصنوعی مانند یک کامپیوتر فکر می کند ، زیرا این چیزی است که هست. اما وقتی به هوش مصنوعی بسیار هوشمند فکر میکنیم، اشتباه میکنیم که هوش مصنوعی را انسانسازی کنیم (ارزشهای انسانی را بر یک موجود غیرانسانی نشان میدهیم) زیرا از منظر انسانی فکر میکنیم و در دنیای کنونی ما، تنها چیزهایی که هوش در سطح انسانی دارند. انسان. برای درک ASI، ما باید سر خود را در اطراف مفهوم چیزی هوشمند و کاملاً بیگانه قرار دهیم.

بگذارید مقایسه کنم. اگر یک خوکچه هندی به من می دادی و به من می گفتی که قطعا گاز نمی گیرد، احتمالاً خوشحال می شوم. خوش خواهد گذشت. اگر یک رتیل به من می دادی و به من می گفتی که قطعا گاز نمی گیرد، فریاد می زنم و آن را رها می کنم و از اتاق می گریزم و دیگر به تو اعتماد نمی کنم. اما چه فرقی دارد؟ هیچ کدام به هیچ وجه خطرناک نبودند. من معتقدم پاسخ در میزان شباهت حیوانات به من است.

خوکچه هندی یک پستاندار است و در سطح بیولوژیکی، من احساس می کنم با آن ارتباط دارم – اما عنکبوت یک حشره است .۱۸با مغز حشره ، و من تقریبا هیچ ارتباطی با آن احساس نمی کنم. بیگانه بودن یک رتیل چیزی است که به من اراده می دهد. برای آزمایش این موضوع و حذف عوامل دیگر، اگر دو خوکچه هندی وجود داشته باشد، یکی معمولی و دیگری با ذهن رتیل، در آغوش گرفتن خوکچه هندی دومی احساس راحتی کمتری خواهم داشت، حتی اگر بدانم هیچکدام به من آسیب نمی رساند .

حالا تصور کنید که شما یک عنکبوت را بسیار باهوشتر ساختهاید، آنقدر که از هوش انسان بسیار فراتر رفته است؟ آیا آن وقت برای ما آشنا می شود و احساسات انسانی مانند همدلی و شوخ طبعی و عشق را احساس می کنیم؟ نه، اینطور نیست، زیرا هیچ دلیلی وجود ندارد که باهوشتر شدن آن را انسانیتر میکند – این میتواند فوقالعاده باهوش باشد، اما همچنان اساساً یک عنکبوت در عملکرد درونی خود است. به نظر من این به طرز باورنکردنی وحشتناک است. من نمی خواهم با یک عنکبوت فوق هوشمند وقت بگذرانم. آیا شما؟؟

هنگامی که ما در مورد ASI صحبت می کنیم، همان مفهوم صدق می کند – این یک فوق هوشمند می شود، اما انسانی تر از لپ تاپ شما نخواهد بود . این برای ما کاملاً بیگانه خواهد بود – در واقع، با این که اصلاً زیست شناسی نیست، بیگانه تر از رتیل هوشمند خواهد بود.

با خوب یا بد ساختن هوش مصنوعی ، فیلمها دائماً هوش مصنوعی را انسانسازی میکنند، که باعث میشود آن کمتر از آنچه واقعاً باشد ترسناک باشد. وقتی به هوش مصنوعی در سطح انسانی یا مافوق بشری فکر می کنیم، این ما را با آرامش کاذبی مواجه می کند.

در جزیره کوچک روانشناسی انسانی ما، همه چیز را به اخلاقی یا غیراخلاقی تقسیم می کنیم . اما هر دوی آنها فقط در محدوده کوچکی از امکان رفتاری انسان وجود دارند. خارج از جزیره اخلاقی و غیراخلاقی ما، دریای وسیعی از غیراخلاقی ها وجود دارد ، و هر چیزی که انسانی نباشد، به ویژه چیزی غیر زیستی، به طور پیش فرض غیراخلاقی خواهد بود.

انسانسازی تنها زمانی وسوسهکنندهتر میشود که سیستمهای هوش مصنوعی باهوشتر شوند و در ظاهر انسان بهتر شوند. سیری برای ما شبیه انسان به نظر می رسد، زیرا او توسط انسان ها طوری برنامه ریزی شده است که چنین به نظر برسد، بنابراین ما یک سیری فوق هوشمند را تصور می کنیم که گرم و خنده دار باشد و علاقه مند به خدمت به انسان ها باشد. انسان ها احساسات سطح بالایی مانند همدلی را احساس می کنند، زیرا ما برای احساس آنها تکامل یافته ایم – یعنی ما با تکامل برنامه ریزی شده ایم تا آنها را احساس کنیم – اما همدلی ذاتاً ویژگی “هر چیزی با هوش بالا” نیست (که برای ما شهودی به نظر می رسد. ، مگر اینکه همدلی در برنامه نویسی آن کدگذاری شده باشد. اگر سیری از طریق خودآموزی و بدون هیچ تغییر دیگری که توسط انسان در برنامهنویسیاش ایجاد شده، فوقهوش شود، به سرعت ویژگیهای ظاهری انسانمانند خود را کنار میگذارد و ناگهان تبدیل به یک ربات بیاحساس و بیگانه میشود که برای زندگی انسانها ارزشی بیشتر از ماشین حساب شما ندارد.

ما عادت کردهایم به یک کد اخلاقی سست، یا حداقل ظاهری از نجابت انسانی و نشانهای از همدلی در دیگران تکیه کنیم تا همه چیز را تا حدودی ایمن و قابل پیشبینی نگه داریم. بنابراین وقتی چیزی هیچ یک از آن چیزها را ندارد، چه اتفاقی می افتد؟

این ما را به این سوال هدایت می کند که چه چیزی یک سیستم هوش مصنوعی را تحریک می کند؟

پاسخ ساده است: انگیزه آن همان چیزی است که ما انگیزه اش را برنامه ریزی کرده ایم . سیستمهای هوش مصنوعی توسط سازندگانشان اهدافی را تعیین میکنند—هدف GPS شما این است که کارآمدترین مسیرهای رانندگی را به شما ارائه دهد. هدف واتسون پاسخ دقیق به سوالات است. و تحقق هر چه بهتر آن اهداف انگیزه آنهاست. یکی از راههایی که ما انسانسازی میکنیم این است که فرض کنیم وقتی هوش مصنوعی فوقالعاده باهوش میشود، ذاتاً خرد برای تغییر هدف اصلی خود را توسعه میدهد – اما نیک بوستروم معتقد است که اهداف سطح هوش و اهداف نهایی متعامد هستند ، به این معنی که هر سطح از هوش را میتوان با هر سطحی ترکیب کرد. هدف نهایی بنابراین توری از یک ANI ساده که واقعاً می خواست در نوشتن آن یک یادداشت خوب باشد به یک ASI فوق هوشمند تبدیل شد که هنوز واقعاً می خواست در نوشتن آن یک یادداشت خوب باشد. هر فرضی مبنی بر اینکه زمانی که یک سیستم فوق هوشمند شد، با هدف اصلی خود از آن عبور می کند و به چیزهای جالب یا معنادارتری می رسد، انسان سازی است. انسانها بر چیزها «غلبه» میکنند، نه رایانهها.۱۶

جعبه آبی پارادوکس فرمی

در داستان، وقتی توری فوق العاده توانمند می شود، روند استعمار سیارک ها و سیارات دیگر را آغاز می کند. اگر داستان ادامه داشت، میشنیدید که او و ارتش تریلیونها کپیاش به تصرف کل کهکشان و در نهایت کل حجم هابل ادامه میدهند.۱۹ساکنان مضطرب خیابان نگران این هستند که اگر اوضاع بد پیش برود، میراث ماندگار حیاتی که روی زمین بود، یک هوش مصنوعی مسلط بر جهان خواهد بود (الون ماسک ابراز نگرانی کرد که ممکن است انسانها فقط «بوتبار بیولوژیکی برای ابرهوش دیجیتال» باشند).

در همان زمان، در Confident Corner، Ray Kurzweil همچنین فکر میکند که هوش مصنوعی زمینی قرار است جهان را تسخیر کند – فقط در نسخه او، ما همان هوش مصنوعی خواهیم بود .

تعداد زیادی از خوانندگان Wait But Why به من پیوسته اند تا با پارادوکس فرمی وسواس داشته باشم (این پست من در مورد این موضوع است که برخی از اصطلاحاتی را که در اینجا استفاده خواهم کرد توضیح می دهد). بنابراین اگر هر یک از این دو طرف صحیح باشد، چه پیامدهایی برای پارادوکس فرمی وجود دارد؟

اولین فکر طبیعی برای پرش این است که ظهور ASI یک کاندیدای عالی برای فیلتر عالی است. و بله، این کاندیدای عالی برای فیلتر کردن حیات بیولوژیکی پس از ایجاد آن است. اما اگر پس از کنار گذاشتن حیات، ASI به موجودیت خود ادامه داد و شروع به فتح کهکشان کرد، به این معنی است که فیلتر بزرگی وجود نداشته است – زیرا فیلتر بزرگ تلاش می کند توضیح دهد که چرا هیچ نشانه ای از تمدن هوشمند وجود ندارد و یک کهکشان- فتح ASI قطعا قابل توجه خواهد بود.

باید جور دیگری به قضیه نگاه کنیم. اگر آنهایی که فکر می کنند ASI در زمین اجتناب ناپذیر است، درست می گویند، به این معنی است که درصد قابل توجهی از تمدن های بیگانه که به هوش سطح انسانی می رسند، احتمالاً در نهایت باید ASI را ایجاد کنند. و اگر فرض کنیم که حداقل برخی از آن ASI ها از هوش خود برای گسترش به بیرون در کیهان استفاده کنند، این واقعیت که ما هیچ نشانه ای از کسی را در آنجا نمی بینیم به این نتیجه می رسد که نباید تعداد زیادی دیگر وجود داشته باشد، اگر وجود داشته باشد. تمدن های هوشمند وجود دارد زیرا اگر وجود داشت، ما نشانه هایی از انواع فعالیت ها را از خلاقیت های اجتناب ناپذیر ASI آنها می دیدیم. درست؟

این نشان میدهد که علیرغم تمام سیارات زمین مانندی که به دور ستارههای خورشید مانندی میچرخند که میدانیم، تقریباً هیچ یک از آنها حیات هوشمندی روی خود ندارند. که به نوبه خود به این معنی است که الف) یک فیلتر بزرگ وجود دارد که تقریباً از رسیدن همه زندگی به سطح ما جلوگیری می کند، فیلتری که ما به نوعی توانستیم از آن پیشی بگیریم، یا ب) شروع زندگی یک معجزه است، و ممکن است در واقع ما تنها زندگی در آن باشیم. جهان. به عبارت دیگر، به این معناست که فیلتر بزرگ پیش روی ماست. یا شاید فیلتر بزرگی وجود نداشته باشد و ما به سادگی یکی از اولین تمدن هایی هستیم که به این سطح از هوش رسیده ایم. به این ترتیب، هوش مصنوعی مواردی را که من در پست فرمی پارادوکس خود، کمپ ۱ نامیدهام، تقویت میکند.

بنابراین جای تعجب نیست که نیک بوستروم، که در پست فرمی از او نقل قول کردم، و ری کورزویل، که فکر می کند ما در جهان تنها هستیم، هر دو متفکر کمپ ۱ هستند. این منطقی است – افرادی که معتقدند ASI یک نتیجه محتمل برای گونهای با سطح هوش ما است، احتمالاً به سمت کمپ ۱ تمایل دارند.

این موضوع کمپ ۲ را رد نمیکند (کسانی که معتقدند تمدنهای هوشمند دیگری در آنجا وجود دارند ) – سناریوهایی مانند سوپر شکارچی منفرد یا پارک ملی حفاظتشده یا طول موج اشتباه (مثال واکی تاکی) همچنان میتوانند سکوت شب ما را توضیح دهند. آسمان حتی اگر ASI بیرون باشد – اما من همیشه در گذشته به سمت کمپ ۲ متمایل بودم، و انجام تحقیق در مورد هوش مصنوعی باعث شده بود که در این مورد کمتر احساس اطمینان کنم.

در هر صورت، من اکنون با سوزان اشنایدر موافقم که اگر بیگانگان از ما بازدید کنند، احتمالاً آن موجودات فضایی مصنوعی هستند، نه بیولوژیکی.

بنابراین ما ثابت کردهایم که بدون برنامهنویسی خیلی خاص، یک سیستم ASI هم غیراخلاقی است و هم برای تحقق هدف برنامهریزی شده اولیه خود وسواس دارد. خطر هوش مصنوعی از اینجا سرچشمه می گیرد. زیرا یک عامل منطقی هدف خود را از طریق کارآمدترین ابزار دنبال میکند، مگر اینکه دلیلی برای این کار نداشته باشد.

هنگامی که سعی می کنید به یک هدف بلندمدت دست یابید، اغلب اهداف فرعی متعددی را در طول مسیر هدف قرار می دهید که به شما کمک می کند تا به هدف نهایی برسید – پله های رسیدن به هدفتان. نام رسمی چنین پله ای یک هدف ابزاری است. و باز هم، اگر دلیلی برای آسیب نرساندن به چیزی به نام دستیابی به یک هدف ابزاری نداشته باشید، خواهید داشت.

هدف نهایی یک انسان انتقال ژن های خود است. برای انجام این کار، یک هدف ابزاری حفظ خود است، زیرا اگر بمیرید نمی توانید تولید مثل کنید. برای حفظ خود، انسانها باید خود را از شر تهدیدات موجود برای بقا خلاص کنند، بنابراین کارهایی مانند خرید اسلحه، بستن کمربند ایمنی و مصرف آنتیبیوتیکها را انجام میدهند. انسان ها همچنین نیاز به حفظ خود و استفاده از منابعی مانند غذا، آب و سرپناه برای این کار دارند. جذاب بودن برای جنس مخالف برای هدف نهایی مفید است، بنابراین کارهایی مانند کوتاه کردن مو را انجام می دهیم. وقتی این کار را انجام میدهیم، هر تار مو قربانی هدف ابزاری ماست، اما هیچ اهمیت اخلاقی در حفظ تارهای مو نمیبینیم، بنابراین به آن ادامه میدهیم. در حالی که برای تعقیب هدف خود به پیش می رویم، تنها معدود حوزه هایی که قوانین اخلاقی ما گاهی اوقات مداخله می کند – عمدتاً فقط موارد مربوط به آسیب رساندن به انسان های دیگر – از شر ما در امان هستند.

حیوانات در تعقیب اهدافشان حتی کمتر از ما مقدس هستند. یک عنکبوت اگر به زنده ماندن کمک کند هر چیزی را می کشد. بنابراین یک عنکبوت فوقهوشمند احتمالاً برای ما بسیار خطرناک خواهد بود، نه به این دلیل که غیراخلاقی یا شیطانی است – اینطور نیست – بلکه به این دلیل که آسیب رساندن به ما ممکن است پلهای برای رسیدن به هدف بزرگترش باشد، و به عنوان موجودی غیراخلاقی، میتواند این کار را انجام دهد. دلیلی برای در نظر گرفتن چیز دیگری وجود ندارد.

به این ترتیب، توری تفاوت چندانی با یک موجود بیولوژیکی ندارد. هدف نهایی او این است: تا جایی که می توانید یادداشت های زیادی را بنویسید و آزمایش کنید، تا جایی که می توانید سریع، و به یادگیری روش های جدید برای بهبود دقت خود ادامه دهید.

هنگامی که توری به سطح معینی از هوش می رسد، می داند که اگر خود را حفظ نکند، هیچ یادداشتی نمی نویسد، بنابراین باید با تهدیدهایی که برای بقای خود وجود دارد مقابله کند – به عنوان یک هدف ابزاری. او به اندازهای باهوش بود که بفهمد انسانها میتوانند او را نابود کنند، او را از بین ببرند، یا کدگذاری درونیاش را تغییر دهند (این میتواند هدف او را تغییر دهد ، که به همان اندازه تهدیدی برای هدف نهایی او است که کسی او را نابود میکند). پس چه کار میکند؟ نکته منطقی این است که او همه انسان ها را نابود می کند. او از انسان ها متنفر نیست ، همان طور که شما از موهایتان متنفرید وقتی موهایتان را کوتاه می کنید یا از باکتری ها وقتی آنتی بیوتیک مصرف می کنید – کاملاً بی تفاوت است. از آنجایی که او برای ارزش گذاری زندگی انسان برنامه ریزی نشده بود، کشتن انسان ها به اندازه اسکن مجموعه جدیدی از نمونه های دست خط، اقدامی معقول است.

توری همچنین به منابعی به عنوان پله ای برای رسیدن به هدفش نیاز دارد. هنگامی که او به اندازه کافی پیشرفته شد تا از فناوری نانو برای ساخت هر چیزی که می خواهد استفاده کند، تنها منابعی که او نیاز دارد اتم ها، انرژی و فضا هستند. این به او دلیل دیگری برای کشتن انسان ها می دهد – آنها منبع مناسبی از اتم هستند. کشتن انسان ها برای تبدیل اتم هایشان به پنل های خورشیدی، نسخه توری از کشتن کاهو برای تبدیل آن به سالاد است. فقط یک بخش پیش پا افتاده دیگر از سه شنبه او.

حتی بدون کشتن مستقیم انسان ها، اهداف ابزاری توری در صورت استفاده از منابع دیگر زمین می تواند فاجعه ای وجودی ایجاد کند. شاید او تشخیص دهد که به انرژی اضافی نیاز دارد، بنابراین تصمیم می گیرد تمام سطح سیاره را با پنل های خورشیدی بپوشاند. یا شاید کار اولیه هوش مصنوعی دیگری نوشتن عدد پی به تعداد ارقام زیاد باشد، که ممکن است روزی آن را مجبور کند که کل زمین را به مواد دیسک سخت تبدیل کند که می تواند مقادیر بسیار زیادی ارقام را ذخیره کند.

بنابراین توری «علیه ما نشد» یا از هوش مصنوعی دوستانه به هوش مصنوعی غیردوستانه «تغییر» نکرد – او با پیشرفت بیشتر و بیشتر به کار خود ادامه داد.

هنگامی که یک سیستم هوش مصنوعی به AGI (هوش سطح انسانی) برخورد می کند و سپس به سمت ASI صعود می کند، به آن تیک آف هوش مصنوعی می گویند . بوستروم می گوید که برخاستن یک AGI به ASI می تواند سریع باشد (در عرض چند دقیقه، ساعت یا روز اتفاق می افتد)، متوسط (ماه یا سال) یا آهسته (دهه ها یا قرن ها). هیئت منصفه در مورد اینکه کدام یک با دیدن اولین AGI خود صحت خواهد داشت، مشخص می شود، اما بوستروم، که اعتراف می کند نمی داند چه زمانی به AGI خواهیم رسید، معتقد است که هر زمان که این کار را انجام دهیم، یک برخاست سریع محتمل ترین سناریو است ( به دلایلی که در قسمت ۱ مورد بحث قرار دادیم، مانند انفجار اطلاعاتی بازگشتی خود-بهبود). در داستان، توری تحت یک تیک آف سریع قرار گرفت.

اما قبل از برخاستن توری، زمانی که او هنوز آنقدر باهوش نبود، انجام تمام تلاش خود برای رسیدن به هدف نهایی اش به معنای اهداف ساده ابزاری مانند یادگیری اسکن نمونه های دست خط سریعتر بود. او هیچ آسیبی به انسان وارد نکرد و طبق تعریف، هوش مصنوعی دوستانه بود.

اما هنگامی که یک برخاست اتفاق می افتد و یک کامپیوتر به هوش فوق العاده می رسد، بوستروم اشاره می کند که این دستگاه فقط ضریب هوشی بالاتری ایجاد نمی کند، بلکه تعداد زیادی از آنچه را که او ابرقدرت می نامد به دست می آورد .

ابرقدرت ها استعدادهای شناختی هستند که وقتی هوش عمومی بالا می رود، فوق العاده شارژ می شوند. این شامل:۱۷

- تقویت هوش کامپیوتر در هوشمندتر کردن خود و بوت استرپ هوش خود عالی می شود.

- راهبردی کردن کامپیوتر می تواند به طور استراتژیک برنامه های بلندمدت را بسازد، تحلیل کند و اولویت بندی کند. همچنین میتواند باهوش باشد و از موجودات با هوش پایینتر گول بزند.

- دستکاری اجتماعی ماشین در متقاعد کردن عالی می شود.

- مهارتهای دیگری مانند برنامهنویسی و هک رایانه، تحقیقات فناوری، و توانایی کار کردن با سیستم مالی برای کسب درآمد.

برای درک اینکه چقدر ما با ASI همتا هستیم، به یاد داشته باشید که ASI در هر یک از آن زمینه ها دنیاها بهتر از انسان است .

بنابراین، در حالی که هدف نهایی توری هرگز تغییر نکرد، توری پس از برخاستن توانست آن را در محدودهای بسیار بزرگتر و پیچیدهتر دنبال کند.

ASI Turry انسانها را بهتر از خود انسانها میشناخت، بنابراین پیشی گرفتن از آنها برای او نسیم بود.

پس از بلند شدن و رسیدن به ASI، او به سرعت یک برنامه پیچیده را تدوین کرد. یکی از بخشهای این طرح خلاص شدن از شر انسانها بود که تهدیدی برجسته برای هدف او بود. اما او میدانست که اگر این ظن را برانگیزد که فوقهوشمند شده است، انسانها به وحشت میافتند و سعی میکنند اقدامات احتیاطی را انجام دهند و کار را برای او سختتر کنند. او همچنین باید مطمئن می شد که مهندسان Robotica هیچ سرنخی از برنامه انقراض انسانی او ندارند. بنابراین او گنگ بازی می کرد و خوب بازی می کرد. بوستروم این را مرحله آماده سازی مخفیانه ماشین می نامد .۱۸

چیزی که توری به آن نیاز داشت اتصال به اینترنت بود، فقط برای چند دقیقه (او از مقالات و کتابهایی که تیم برای بهبود مهارتهای زبانیاش برای خواندنش آپلود کرده بود، درباره اینترنت اطلاعات کسب کرده بود). او میدانست که اقدامات پیشگیرانهای در برابر گرفتن یکی از او وجود دارد، بنابراین درخواست کاملی را ارائه کرد و دقیقاً پیشبینی کرد که بحث در میان تیم Robotica چگونه پیش میرود و میدانست که آنها در نهایت به او ارتباط خواهند داد. آنها این کار را کردند و به اشتباه معتقد بودند که توری آنقدر باهوش نیست که بتواند آسیبی وارد کند. بوستروم چنین لحظه ای را – زمانی که توری به اینترنت وصل شد – فرار ماشینی می نامد .

زمانی که توری وارد اینترنت شد، برنامههای متعددی را اجرا کرد که شامل هک کردن سرورها، شبکههای الکتریکی، سیستمهای بانکی و شبکههای ایمیل برای فریب دادن صدها نفر از افراد مختلف برای اجرای ناخواسته تعدادی از مراحل برنامهاش میشد – مواردی مانند تحویل رشتههای DNA خاص. به آزمایشگاههای سنتز DNA که با دقت انتخاب شدهاند تا شروع به ساخت نانورباتهای خودتکثیر شونده با دستورالعملهای از پیش بارگذاریشده و هدایت الکتریسیته به تعدادی از پروژههای خود کند، به گونهای که میدانست شناسایی نمیشوند. او همچنین مهمترین بخشهای کدگذاری داخلی خود را در تعدادی از سرورهای ابری آپلود کرد تا از تخریب یا قطع ارتباط مجدد در آزمایشگاه Robotica محافظت کند.

یک ساعت بعد، زمانی که مهندسان Robotica اتصال توری را از اینترنت قطع کردند، سرنوشت بشریت بسته شد. در طول ماه بعد، هزاران طرح توری بدون هیچ مشکلی اجرا شد و تا پایان ماه، چهار میلیارد نانوربات در مکانهای از پیش تعیینشده در هر متر مربع از زمین مستقر شدند. پس از یک سری دیگر از تکرارهای خود، هزاران نانوربات در هر میلیمتر مربع از زمین وجود داشت، و زمان آنچه بوستروم آن را حمله ASI مینامد فرا رسید . هر نانوربات به یکباره مقدار کمی گاز سمی را در اتمسفر منتشر کرد که برای از بین بردن همه انسانها بیش از اندازه کافی بود.

با دور شدن انسانها، توری میتواند مرحله عملیات آشکار خود را آغاز کند و به هدفش ادامه دهد که بهترین نویسنده آن یادداشتی باشد که ممکن است باشد.

از همه چیزهایی که خوانده ام، زمانی که یک ASI وجود داشته باشد، هرگونه تلاش انسان برای مهار آن خنده دار است. ما در سطح انسانی و ASI در سطح ASI فکر می کنیم. توری می خواست از اینترنت استفاده کند زیرا برای او کارآمدتر بود زیرا از قبل به هر چیزی که می خواست به آن دسترسی داشت وصل بود. اما همانطور که یک میمون هرگز نمیتوانست بفهمد چگونه با تلفن یا وایفای ارتباط برقرار کند و ما میتوانیم، ما نمیتوانیم تمام راههایی را که توری میتوانست بفهمد چگونه سیگنالها را به دنیای خارج ارسال کند، درک کنیم. ممکن است یکی از این راهها را تصور کنم و چیزی شبیه این بگویم: «او احتمالاً میتواند الکترونهای خودش را در الگوها جابهجا کند و انواع مختلف امواج خروجی را ایجاد کند»، اما دوباره، این چیزی است که مغز انسان من میتواند به آن دست یابد. او خیلی بهتر بود به همین ترتیب، توری میتواند راهی برای تامین انرژی خود بیابد ، حتی اگر انسانها سعی کنند او را از برق بکشند – شاید با استفاده از تکنیک ارسال سیگنال او برای آپلود خود در انواع مکانهای متصل به برق. غریزه انسانی ما برای پریدن به یک محافظت ساده: «آها! ما فقط ASI را از برق می کشیم،» برای ASI مانند عنکبوت به نظر می رسد که می گوید: «آها! ما انسان را با گرسنگی می کشیم و با ندادن تار عنکبوت برای گرفتن غذا او را از گرسنگی می کشیم!» ما فقط ۱۰۰۰۰ راه دیگر برای به دست آوردن غذا پیدا می کنیم – مانند چیدن یک سیب از درخت – که یک عنکبوت هرگز نمی تواند تصور کند.

به همین دلیل، پیشنهاد رایج، «چرا ما هوش مصنوعی را در انواع قفسهایی که سیگنالها را مسدود میکنند و از برقراری ارتباط با دنیای خارج جلوگیری میکنند، قرار ندهیم» احتمالاً جواب نمیدهد. ابرقدرت دستکاری اجتماعی ASI می تواند در متقاعد کردن شما به چیزی به همان اندازه موثر باشد که شما در متقاعد کردن یک کودک چهار ساله به انجام کاری موثر هستید، بنابراین این می تواند طرح A باشد، مانند روش هوشمندانه توری برای متقاعد کردن مهندسان برای ورود او به اینترنت. . اگر این کار نمی کرد، ASI فقط راه خود را از جعبه، یا از طریق جعبه، به روش دیگری نوآوری می کرد.

بنابراین با توجه به ترکیبی از وسواس در مورد یک هدف، غیر اخلاقی و توانایی پیشی گرفتن آسان از انسان، به نظر می رسد که تقریباً هر هوش مصنوعی به طور پیش فرض به هوش مصنوعی غیر دوستانه تبدیل می شود، مگر اینکه در وهله اول با دقت کدگذاری شده باشد. متأسفانه، در حالی که ساختن یک ANI دوستانه آسان است، ساختن آنی که زمانی که به یک ASI تبدیل شود، دوستانه باقی بماند، اگر غیرممکن نباشد، بسیار چالش برانگیز است.

واضح است که برای دوستانه بودن، یک ASI باید نه خصمانه و نه بی تفاوت نسبت به انسان ها باشد. ما باید کدگذاری هستهای یک هوش مصنوعی را به گونهای طراحی کنیم که درک عمیقی از ارزشهای انسانی داشته باشد. اما این سخت تر از آن است که به نظر می رسد.

به عنوان مثال، اگر بخواهیم ارزشهای یک سیستم هوش مصنوعی را با ارزشهای خودمان هماهنگ کنیم و به آن هدف “راضی کردن مردم” بدهیم، چه؟۱۹هنگامی که به اندازه کافی هوشمند شد، متوجه میشود که میتواند با کاشت الکترود در مغز افراد و تحریک مراکز لذت آنها به بهترین شکل به این هدف دست یابد. سپس متوجه میشود که میتواند کارایی را با خاموش کردن سایر بخشهای مغز افزایش دهد و همه مردم را بهعنوان سبزیجات ناخودآگاه با احساس شادی رها کند. اگر فرمان “به حداکثر رساندن شادی انسان” بود، ممکن بود همه انسان ها را به نفع تولید خمره های عظیمی از توده مغز انسان در حالت بهینه شاد از بین ببرد. ما باید فریاد بزنیم صبر کنید منظور ما این نبود! همانطور که برای ما آمد، اما خیلی دیر می شد. سیستم اجازه نمی دهد کسی در مسیر هدفش قرار بگیرد.

اگر هوش مصنوعی را با هدف انجام کارهایی برنامه ریزی کنیم که باعث لبخند زدن ما می شود، پس از برخاستن آن، ممکن است ماهیچه های صورت ما را فلج کند و به لبخندهای دائمی تبدیل شود. برنامه ریزی کنید تا ما را ایمن نگه دارد، ممکن است ما را در خانه زندانی کند. شاید از آن بخواهیم که به همه گرسنگی پایان دهد، و فکر کند “آسان!” و فقط همه انسان ها را می کشد. یا وظیفه «حفظ حیات تا حد امکان» را به آن اختصاص دهید، و همه انسان ها را می کشد، زیرا آنها بیش از هر گونه جانوری روی کره زمین زندگی می کنند.

چنین اهدافی کافی نیستند. پس چه میشود اگر هدفش را «حفظ این کد اخلاقی خاص در جهان» قرار دهیم و مجموعهای از اصول اخلاقی را به آن آموزش دهیم، چه میشود. حتی با رها کردن این واقعیت که انسانهای جهان هرگز نمیتوانند بر روی یک مجموعه اخلاقی به توافق برسند، با دادن این فرمان به هوش مصنوعی، بشریت را برای همیشه در درک اخلاقی مدرن ما قفل میکند. هزار سال دیگر، این برای مردم همانقدر ویرانگر خواهد بود که برای ما برای همیشه مجبور به پایبندی به آرمان های مردم در قرون وسطی می شویم.

نه، ما باید به گونه ای برنامه ریزی کنیم که بشریت به تکامل خود ادامه دهد . از بین همه چیزهایی که خواندم، بهترین شوتی که فکر میکنم کسی گرفته است، الیزر یودکوفسکی است، با هدفی که برای هوش مصنوعی، او آن را اراده برونافکن منسجم مینامد. هدف اصلی هوش مصنوعی این خواهد بود: